Probabilidade Condicional - Conditional probability

| Parte de uma série de estatísticas |

| Teoria da probabilidade |

|---|

|

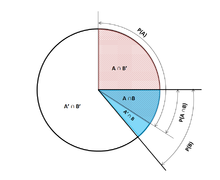

Na teoria da probabilidade , a probabilidade condicional é uma medida da probabilidade de um evento ocorrer, dado que outro evento (por suposição, suposição, afirmação ou evidência) já ocorreu. Se o evento de interesse é A e o evento B é conhecido ou presumido que ocorreu, "a probabilidade condicional de A dado B ", ou "a probabilidade de A sob a condição B ", é geralmente escrita como P ( A | B ) ou ocasionalmente P B ( A ) . Isto também pode ser entendida como a fracção de probabilidade B que se cruza com A: .

Por exemplo, a probabilidade de qualquer pessoa ter tosse em um determinado dia pode ser de apenas 5%. Mas se soubermos ou presumirmos que a pessoa está doente, é muito mais provável que ela esteja tossindo. Por exemplo, a probabilidade condicional de que alguém não está tossindo pode ser 75%, caso em que teríamos que P (Tosse) = 5% e P (Tosse | Doente) = 75%. Porém, não precisa haver relação ou dependência entre A e B , e eles não precisam ocorrer simultaneamente.

P ( A | B ) pode ou não ser igual a P ( A ) (a probabilidade incondicional de A ). Se P ( A | B ) = P ( A ) , então os eventos A e B são considerados independentes : em tal caso, o conhecimento sobre qualquer um dos eventos não altera a probabilidade um do outro. P ( A | B ) (a probabilidade condicional de A dado B ) difere tipicamente de P ( B | A ) . Por exemplo, se uma pessoa tem dengue , ela pode ter 90% de chance de teste positivo para a doença. Nesse caso, o que está sendo medido é que se o evento B ( ter dengue ) ocorreu, a probabilidade de A ( teste positivo ) dado que B ocorreu é de 90%: P ( A | B ) = 90%. Alternativamente, se o teste de uma pessoa for positivo para dengue, ela pode ter apenas 15% de chance de realmente ter essa doença rara devido às altas taxas de falsos positivos . Nesse caso, a probabilidade do evento B ( ter dengue ), dado que o evento A ( teste positivo ) ocorreu é de 15%: P ( B | A ) = 15%. Deve ser aparente agora que equacionando falsamente as duas probabilidades pode levar a vários erros de raciocínio, o que é comumente visto por meio de falácias de taxa básica .

Embora as probabilidades condicionais possam fornecer informações extremamente úteis, muitas vezes são fornecidas informações limitadas ou disponíveis. Portanto, ele pode ser útil para reverter ou converter uma probabilidade condição usando o teorema de Bayes : . Outra opção é exibir probabilidades condicionais na tabela de probabilidade condicional para iluminar a relação entre os eventos.

Definição

Condicionamento em um evento

Definição de Kolmogorov

Dados dois eventos A e B do campo sigma de um espaço de probabilidade, com a probabilidade incondicional de B ser maior que zero (ou seja, P ( B )> 0) , a probabilidade condicional de A dado B é definida como o quociente da probabilidade da junção dos eventos A e B , e a probabilidade de B :

onde é a probabilidade de que os eventos A e B ocorram. Isso pode ser visualizado como restringindo o espaço da amostra para situações em que B ocorre. A lógica por trás dessa equação é que se os resultados possíveis para A e B são restritos àqueles em que B ocorre, este conjunto serve como o novo espaço amostral.

Observe que a equação acima é uma definição - não um resultado teórico. Nós apenas denotam a quantidade como , e chamá-lo a probabilidade condicional de uma dada B .

Como um axioma de probabilidade

Alguns autores, como de Finetti , preferem introduzir a probabilidade condicional como um axioma de probabilidade :

Embora matematicamente equivalente, isso pode ser preferido filosoficamente; sob as principais interpretações de probabilidade , como a teoria subjetiva , a probabilidade condicional é considerada uma entidade primitiva. Além disso, esta "regra de multiplicação" pode ser praticamente útil no cálculo da probabilidade de e introduz uma simetria com o axioma de soma para eventos mutuamente exclusivos :

Como a probabilidade de um evento condicional

A probabilidade condicional pode ser definida como a probabilidade de um evento condicional . O evento condicional Goodman-Nguyen-Van Fraassen pode ser definido como

Pode-se mostrar que

que atende à definição de probabilidade condicional de Kolmogorov.

Condicionamento em um evento de probabilidade zero

Se , então de acordo com a definição, é indefinido .

O caso de maior interesse é o de uma variável aleatória Y , condicionada a uma variável aleatória contínua X resultando em um determinado resultado x . O evento tem probabilidade zero e, como tal, não pode ser condicionado.

Em vez de condicionar em X sendo exatamente x , poderíamos condicionar que ele esteja mais próximo do que a distância de x . O evento geralmente terá probabilidade diferente de zero e, portanto, pode ser condicionado. Podemos então pegar o limite

Por exemplo, se duas variáveis aleatórias contínuas X e Y têm uma densidade conjunta , então pela regra de L'Hôpital :

O limite resultante é a distribuição de probabilidade condicional de Y dado X e existe quando o denominador, a densidade de probabilidade , é estritamente positivo.

É tentador definir a probabilidade indefinida usando esse limite, mas isso não pode ser feito de maneira consistente. Em particular, é possível encontrar variáveis aleatórias X e W e valores x , w de modo que os eventos e sejam idênticos, mas os limites resultantes não sejam:

O paradoxo Borel – Kolmogorov demonstra isso com um argumento geométrico.

Condicionamento em uma variável aleatória discreta

Deixe X ser uma variável aleatória discreta e seus possíveis resultados denotado V . Por exemplo, se X representa o valor de um dado rolado, então V é o conjunto . Vamos supor, para fins de apresentação, que X é uma variável aleatória discreta, de modo que cada valor em V tem uma probabilidade diferente de zero.

Para um valor x em V e um evento A , a probabilidade condicional é dada por . Escrita

para breve, vemos que ela é uma função de duas variáveis, x e A .

Para um A fixo , podemos formar a variável aleatória . Representa um resultado de sempre que um valor x de X é observado.

A probabilidade condicional de A dado X pode, portanto, ser tratada como uma variável aleatória Y com resultados no intervalo . A partir da lei da probabilidade total , o seu valor esperado é igual ao incondicional probabilidade de Uma .

Probabilidade condicional parcial

A probabilidade condicional parcial é sobre a probabilidade de evento, dado que cada um dos eventos de condição ocorreu em um grau (grau de crença, grau de experiência) que pode ser diferente de 100%. Freqüentemente, a probabilidade condicional parcial faz sentido, se as condições forem testadas em repetições de experimentos de comprimento apropriado . Essa probabilidade condicional parcial limitada pode ser definida como a ocorrência média condicionalmente esperada de evento em bancos de teste de comprimento que aderem a todas as especificações de probabilidade , ou seja:

Com base nisso, a probabilidade condicional parcial pode ser definida como

Onde

A condicionalização de Jeffrey é um caso especial de probabilidade condicional parcial, em que os eventos de condição devem formar uma partição :

Exemplo

Suponha que alguém secretamente rola dois justos seis lados dados , e queremos calcular a probabilidade de que o valor de face para cima do primeiro é 2, dada a informação que a sua soma não é maior que 5.

Probabilidade de que D 1 = 2

A Tabela 1 mostra o espaço amostral de 36 combinações de valores lançados dos dois dados, cada um dos quais ocorre com probabilidade 1/36, com os números exibidos nas células vermelho e cinza escuro sendo D 1 + D 2 .

D 1 = 2 em exatamente 6 dos 36 resultados; assim, P ( D 1 = 2) = 6 ⁄ 36 = 1 ⁄ 6 :

tabela 1 + D 2 1 2 3 4 5 6 D 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Probabilidade de que D 1 + D 2 ≤ 5

A Tabela 2 mostra que D 1 + D 2 ≤ 5 para exatamente 10 dos 36 resultados, assim, P ( D 1 + D 2 ≤ 5) = 10 ⁄ 36 :

mesa 2 + D 2 1 2 3 4 5 6 D 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Probabilidade de que D 1 = 2 dado que D 1 + D 2 ≤ 5

A Tabela 3 mostra que para 3 desses 10 resultados, D 1 = 2.

Assim, a probabilidade condicional P ( D 1 = 2 | D 1 + D 2 ≤ 5) = 3 ⁄ 10 = 0,3:

Tabela 3 + D 2 1 2 3 4 5 6 D 1 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12

Aqui, na notação anterior para a definição de probabilidade condicional, o evento condicionante B é que D 1 + D 2 ≤ 5, e o evento A é D 1 = 2. Como visto na tabela.

Use em inferência

Na inferência estatística , a probabilidade condicional é uma atualização da probabilidade de um evento com base em novas informações. As novas informações podem ser incorporadas da seguinte forma:

- Seja A , o evento de interesse, no espaço amostral , digamos ( X , P ).

- A ocorrência do evento A sabendo que o evento B ocorreu ou terá ocorrido, significa a ocorrência de A , pois está restrito a B , ou seja .

- Sem o conhecimento da ocorrência de B , a informação sobre a ocorrência de A seria simplesmente P ( A )

- A probabilidade de A saber que o evento B ocorreu ou terá ocorrido, será a probabilidade de, em relação a P ( B ), a probabilidade de que B tenha ocorrido.

- Isso resulta em sempre que P ( B )> 0 e 0 caso contrário.

Essa abordagem resulta em uma medida de probabilidade que é consistente com a medida de probabilidade original e satisfaz todos os axiomas de Kolmogorov . Essa medida de probabilidade condicional também poderia ter resultado assumindo que a magnitude relativa da probabilidade de A em relação a X será preservada em relação a B (cf. uma Derivação formal abaixo).

A expressão "evidência" ou "informação" é geralmente usada na interpretação bayesiana da probabilidade . O evento condicionante é interpretado como evidência do evento condicionado. Ou seja, P ( A ) é a probabilidade de A antes da contabilização da evidência E , e P ( A | E ) é a probabilidade de A após ter contabilizado a evidência E ou após ter atualizado P ( A ). Isso é consistente com a interpretação frequentista, que é a primeira definição dada acima.

Independência estatística

Os eventos A e B são definidos para serem estatisticamente independentes se

Se P ( B ) não for zero, isso é equivalente à afirmação de que

Da mesma forma, se P ( A ) não for zero, então

também é equivalente. Embora as formas derivadas pode parecer mais intuitiva, eles não são a definição preferida como as probabilidades condicionais pode ser indefinido, e a definição preferida é simétrico em um e B .

Eventos independentes vs. eventos mutuamente exclusivos

Os conceitos de eventos mutuamente independentes e eventos mutuamente exclusivos são separados e distintos. A tabela a seguir compara os resultados dos dois casos (desde que a probabilidade do evento condicionante não seja zero).

| Se estatisticamente independente | Se mutuamente exclusivo | |

|---|---|---|

| 0 | ||

| 0 | ||

| 0 |

Na verdade, eventos mutuamente exclusivos não podem ser estatisticamente independentes (a menos que ambos sejam impossíveis), uma vez que saber que um ocorre fornece informações sobre o outro (em particular, que o último certamente não ocorrerá).

Falácias comuns

- Essas falácias não devem ser confundidas com a "falácia condicional" de Robert K. Shope de 1978 , que lida com exemplos contrafatuais que imploram pela questão .

Assumindo que a probabilidade condicional é de tamanho semelhante ao seu inverso

Em geral, não se pode assumir que P ( A | B ) ≈ P ( B | A ). Isso pode ser um erro insidioso, mesmo para aqueles que estão muito familiarizados com estatísticas. A relação entre P ( A | B ) e P ( B | A ) é dada pelo teorema de Bayes :

Ou seja, P ( A | B ) ≈ P ( B | A ) somente se P ( B ) / P ( A ) ≈ 1, ou equivalentemente, P ( A ) ≈ P ( B ).

Assumindo que as probabilidades marginais e condicionais são de tamanho semelhante

Em geral, não se pode assumir que P ( A ) ≈ P ( A | B ). Essas probabilidades estão ligadas pela lei da probabilidade total :

onde os eventos formam uma partição contável de .

Essa falácia pode surgir por meio do viés de seleção . Por exemplo, no contexto de um pedido médico, deixe S C ser o caso em que uma sequela (doença crónica) S ocorre como uma consequência da circunstância (condição aguda) C . Seja H o evento em que um indivíduo procura ajuda médica. Suponha que, na maioria dos casos, C não cause S (de modo que P ( S C ) é baixo). Suponha também que a atenção médica só é procurado se S ocorreu devido a C . Com base na experiência dos pacientes, um médico pode, portanto, concluir erroneamente que o P ( S C ) é alto. A probabilidade real observada pelo médico é P ( S C | H ).

Prioridades com peso excessivo ou insuficiente

Não levar em consideração a probabilidade anterior parcial ou totalmente é chamado de negligência da taxa básica . O inverso, o ajuste insuficiente da probabilidade anterior é conservadorismo .

Derivação formal

Formalmente, P ( A | B ) é definido como a probabilidade de A de acordo com uma nova função de probabilidade no espaço amostral, de modo que os resultados que não estão em B tenham probabilidade 0 e que seja consistente com todas as medidas de probabilidade originais .

Seja Ω um espaço amostral com eventos elementares { ω }, e seja P a medida de probabilidade em relação à σ-álgebra de Ω. Suponha que nos digam que o evento B ⊆ Ω ocorreu. Uma nova distribuição de probabilidade (denotada pela notação condicional) deve ser atribuída em { ω } para refletir isso. Todos os eventos que não estão em B terão probabilidade nula na nova distribuição. Para eventos em B , duas condições devem ser atendidas: a probabilidade de B é um e as magnitudes relativas das probabilidades devem ser preservadas. O primeiro é exigido pelos axiomas de probabilidade , e o último decorre do fato de que a nova medida de probabilidade tem que ser o análogo de P em que a probabilidade de B é um - e todo evento que não está em B , portanto, tem uma probabilidade nula. Portanto, para algum fator de escala α , a nova distribuição deve satisfazer:

Substituindo 1 e 2 em 3 para selecionar α :

Portanto, a nova distribuição de probabilidade é

Agora, para um evento geral A ,

Veja também

- Teorema de Bayes

- Epistemologia bayesiana

- Paradoxo de Borel-Kolmogorov

- Regra da cadeia (probabilidade)

- Probabilidades de associação à classe

- Independência condicional

- Distribuição de probabilidade condicional

- Condicionamento (probabilidade)

- Distribuição de probabilidade conjunta

- Problema Monty Hall

- Distribuição independente de pares

- Probabilidade posterior

- Probabilidade condicional regular

Referências

links externos

- Weisstein, Eric W. "Conditional Probability" . MathWorld .

- F. Thomas Bruss Der Wyatt-Earp-Effekt oder die betörende Macht kleiner Wahrscheinlichkeiten (em alemão), Spektrum der Wissenschaft (Edição alemã da Scientific American), Vol 2, 110-113, (2007).

- Explicação visual da probabilidade condicional

![[0,1]](https://wikimedia.org/api/rest_v1/media/math/render/svg/738f7d23bb2d9642bab520020873cccbef49768d)

![{\ displaystyle {\ begin {alinhados} 1 & = \ sum _ {\ omega \ in \ Omega} {P (\ omega \ mid B)} \\ & = \ sum _ {\ omega \ in B} {P (\ omega \ mid B)} + {\ cancelto {0} {\ sum _ {\ omega \ notin B} P (\ omega \ mid B)}} \\ & = \ alpha \ sum _ {\ omega \ in B} {P (\ omega)} \\ [5pt] & = \ alpha \ cdot P (B) \\ [5pt] \ Rightarrow \ alpha & = {\ frac {1} {P (B)}} \ end {alinhado }}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bc21b49c38af5566aeb4794016be9ee06b40458c)

![{\ displaystyle {\ begin {alinhados} P (A \ mid B) & = \ sum _ {\ omega \ in A \ cap B} {P (\ omega \ mid B)} + {\ cancelto {0} {\ sum _ {\ omega \ in A \ cap B ^ {c}} P (\ omega \ mid B)}} \\ & = \ sum _ {\ omega \ in A \ cap B} {\ frac {P (\ omega)} {P (B)}} \\ [5pt] & = {\ frac {P (A \ cap B)} {P (B)}} \ end {alinhado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4f6e98f9200e5cf74a15231fc3c753ccfeb8d1c6)