Medida de covariância de componentes de um vetor aleatório

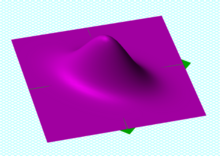

Pontos de amostra de uma

distribuição gaussiana bivariada com um desvio padrão de 3 em aproximadamente a direção inferior esquerda-superior direita e de 1 na direção ortogonal. Porque a

x e

y componentes co-variar, o variâncias de e não descrevem totalmente a distribuição. Uma matriz de covariância é necessária; as direções das setas correspondem aos

autovetores dessa matriz de covariância e seus comprimentos às raízes quadradas dos autovalores .

Na teoria das probabilidades e estatísticas , uma matriz de covariância (também conhecido como matriz auto-covariância , matriz de dispersão , matriz de variância , ou matriz de variância-covariância ) é um quadrado matriz que dá a covariância entre cada par de elementos de um determinado vector aleatório . Qualquer matriz de covariância é simétrica e semi-definida positiva e sua diagonal principal contém variâncias (ou seja, a covariância de cada elemento consigo mesmo).

Intuitivamente, a matriz de covariância generaliza a noção de variância para dimensões múltiplas. Por exemplo, a variação em uma coleção de pontos aleatórios no espaço bidimensional não pode ser caracterizada totalmente por um único número, nem as variações nas direções e conteriam todas as informações necessárias; uma matriz seria necessária para caracterizar completamente a variação bidimensional.

A matriz de covariância de um vetor aleatório é normalmente denotada por ou .

Definição

Ao longo deste artigo, em negrito unsubscripted e são usados para se referir a vetores aleatórios, e unboldfaced subscritos e são usados para se referir a variáveis aleatórias escalares.

Se as entradas no vetor coluna

são variáveis aleatórias , cada uma com variância finita e valor esperado , então a matriz de covariância é a matriz cuja entrada é a covariância

![{\ displaystyle \ operatorname {K} _ {X_ {i} X_ {j}} = \ operatorname {cov} [X_ {i}, X_ {j}] = \ operatorname {E} [(X_ {i} - \ operatorname {E} [X_ {i}]) (X_ {j} - \ operatorname {E} [X_ {j}])]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83bec85f5e2cab5d3406677dd806e554a442331f)

onde o operador denota o valor esperado (média) de seu argumento.

Em outras palavras,

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = {\ begin {bmatrix} \ mathrm {E} [(X_ {1} - \ operatorname {E} [X_ {1} ]) (X_ {1} - \ operatorname {E} [X_ {1}])] & \ mathrm {E} [(X_ {1} - \ operatorname {E} [X_ {1}]) (X_ {2 } - \ operatorname {E} [X_ {2}])] & \ cdots & \ mathrm {E} [(X_ {1} - \ operatorname {E} [X_ {1}]) (X_ {n} - \ operatorname {E} [X_ {n}])] \\\\\ mathrm {E} [(X_ {2} - \ operatorname {E} [X_ {2}]) (X_ {1} - \ operatorname {E } [X_ {1}])] & \ mathrm {E} [(X_ {2} - \ operatorname {E} [X_ {2}]) (X_ {2} - \ operatorname {E} [X_ {2} ])] & \ cdots & \ mathrm {E} [(X_ {2} - \ operatorname {E} [X_ {2}]) (X_ {n} - \ operatorname {E} [X_ {n}])] \\\\\ vdots & \ vdots & \ ddots & \ vdots \\\\\ mathrm {E} [(X_ {n} - \ operatorname {E} [X_ {n}]) (X_ {1} - \ operatorname {E} [X_ {1}])] & \ mathrm {E} [(X_ {n} - \ operatorname {E} [X_ {n}]) (X_ {2} - \ operatorname {E} [X_ {2}])] & \ cdots & \ mathrm {E} [(X_ {n} - \ operatorname {E} [X_ {n}]) (X_ {n} - \ operatorname {E} [X_ {n} ])] \ end {bmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/595ae6dc8ee7f0708dbf854a48a8c6bfad7ff8ce)

A definição acima é equivalente à igualdade da matriz

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {cov} [\ mathbf {X}, \ mathbf {X}] = \ operatorname {E} [(\ mathbf {X} - \ mathbf {\ mu _ {X}}) (\ mathbf {X} - \ mathbf {\ mu _ {X}}) ^ {\ rm {T}}] = \ operatorname {E} [\ mathbf {X} \ mathbf {X} ^ {T}] - \ mathbf {\ mu _ {X}} \ mathbf {\ mu _ {X}} ^ {T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2dfbcd40b5e71238b0d3df4fd313ee4c8d5ce98a) |

|

( Eq.1 )

|

onde .

![{\ displaystyle \ mathbf {\ mu _ {X}} = \ operatorname {E} [\ mathbf {X}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d8bfb858b1c1ff6d479e0d41710e4e5be1966fa)

Generalização da variância

Esta forma ( Eq.1 ) pode ser vista como uma generalização da variância com valor escalar para dimensões superiores. Lembre-se de que para uma variável aleatória de valor escalar

![{\ displaystyle \ sigma _ {X} ^ {2} = \ operatorname {var} (X) = \ operatorname {E} [(X- \ operatorname {E} [X]) ^ {2}] = \ operatorname { E} [(X- \ operatorname {E} [X]) \ cdot (X- \ operatorname {E} [X])].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d7298e1f1861406afedda8733e2950b94656c549)

Na verdade, as entradas na diagonal da matriz de autocovariância são as variâncias de cada elemento do vetor .

Nomenclaturas e notações conflitantes

As nomenclaturas diferem. Alguns estatísticos, seguindo o probabilística William Feller em seu livro de dois volumes Uma Introdução à Teoria da Probabilidade e suas aplicações , ligue para a matriz da variância do vetor aleatório , porque é a generalização natural de dimensões superiores da variância 1-dimensional. Outros a chamam de matriz de covariância , porque é a matriz de covariâncias entre os componentes escalares do vetor .

![{\ displaystyle \ operatorname {var} (\ mathbf {X}) = \ operatorname {cov} (\ mathbf {X}) = \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [ \ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}} \ right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cca6689e7e3aad726a5b60052bbd8f704f1b26bf)

Ambas as formas são bastante padronizadas e não há ambigüidade entre elas. A matriz também é freqüentemente chamada de matriz de variância-covariância , uma vez que os termos diagonais são, na verdade, variâncias.

Por comparação, a notação para a matriz de covariância cruzada entre dois vetores é

![{\ displaystyle \ operatorname {cov} (\ mathbf {X}, \ mathbf {Y}) = \ operatorname {K} _ {\ mathbf {X} \ mathbf {Y}} = \ operatorname {E} \ left [( \ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {Y} - \ operatorname {E} [\ mathbf {Y}]) ^ {\ rm {T}} \ right] .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1112b836c2cd9fde4ac076a44dfdbd213395a56b)

Propriedades

Relação com a matriz de autocorrelação

A matriz de autocovariância está relacionada com a matriz de autocorrelação por

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {E} [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}}] = \ operatorname {R} _ {\ mathbf {X} \ mathbf {X}} - \ operatorname { E} [\ mathbf {X}] \ operatorname {E} [\ mathbf {X}] ^ {\ rm {T}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00175de2c055b834a6f012910f7a5a3d1ed96353)

onde a matriz de autocorrelação é definida como .

![{\ displaystyle \ operatorname {R} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {E} [\ mathbf {X} \ mathbf {X} ^ {\ rm {T}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/375369663d22bba80d770f6374289f95dd22cf63)

Relação com a matriz de correlação

Uma entidade intimamente relacionada à matriz de covariância é a matriz dos coeficientes de correlação produto-momento de Pearson entre cada uma das variáveis aleatórias no vetor aleatório , que pode ser escrita como

onde é a matriz dos elementos diagonais de (ou seja, uma matriz diagonal das variâncias de para ).

De forma equivalente, a matriz de correlação pode ser vista como a matriz de covariância das variáveis aleatórias padronizadas para .

![{\ displaystyle \ operatorname {corr} (\ mathbf {X}) = {\ begin {bmatrix} 1 & {\ frac {\ operatorname {E} [(X_ {1} - \ mu _ {1}) (X_ {2 } - \ mu _ {2})]} {\ sigma (X_ {1}) \ sigma (X_ {2})}} & \ cdots & {\ frac {\ operatorname {E} [(X_ {1} - \ mu _ {1}) (X_ {n} - \ mu _ {n})]} {\ sigma (X_ {1}) \ sigma (X_ {n})}} \\\\ {\ frac {\ operatorname {E} [(X_ {2} - \ mu _ {2}) (X_ {1} - \ mu _ {1})]} {\ sigma (X_ {2}) \ sigma (X_ {1}) }} & 1 & \ cdots & {\ frac {\ operatorname {E} [(X_ {2} - \ mu _ {2}) (X_ {n} - \ mu _ {n})]} {\ sigma (X_ { 2}) \ sigma (X_ {n})}} \\\\\ vdots & \ vdots & \ ddots & \ vdots \\\\ {\ frac {\ operatorname {E} [(X_ {n} - \ mu _ {n}) (X_ {1} - \ mu _ {1})]} {\ sigma (X_ {n}) \ sigma (X_ {1})}} & {\ frac {\ operatorname {E} [ (X_ {n} - \ mu _ {n}) (X_ {2} - \ mu _ {2})]} {\ sigma (X_ {n}) \ sigma (X_ {2})}} & \ cdots & 1 \ end {bmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/df091a047aa8a9d829b25f68a5bbe6d56938b146)

Cada elemento na diagonal principal de uma matriz de correlação é a correlação de uma variável aleatória consigo mesma, que sempre é igual a 1. Cada elemento fora da diagonal está entre -1 e +1 inclusive.

Inversa da matriz de covariância

O inverso dessa matriz, se existir, é a matriz de covariância inversa, também conhecida como matriz de concentração ou matriz de precisão .

Propriedades básicas

Para e , onde é uma variável aleatória dimensional, as seguintes propriedades básicas se aplicam:

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {var} (\ mathbf {X}) = \ operatorname {E} \ left [\ left (\ mathbf {X } - \ operatorname {E} [\ mathbf {X}] \ right) \ left (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}] \ right) ^ {\ rm {T}} \ direito]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bed55fb51d1aad5b83b37076bdbd9ad0177a813b)

![{\ displaystyle \ mathbf {\ mu _ {X}} = \ operatorname {E} [{\ textbf {X}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25987aa171cbd6ec023a92eb06b6ee750de39309)

-

é semidefinido positivo , ou seja

é semidefinido positivo , ou seja

-

é simétrico , ou seja

é simétrico , ou seja

- Para qualquer matriz constante (ou seja, não aleatória) e vetor constante , tem-se

- Se for outro vetor aleatório com a mesma dimensão de , então onde está a matriz de covariância cruzada de e .

Matrizes de bloco

A média conjunta e a matriz de covariância conjunta de e podem ser escritas em forma de bloco

onde , e .

e podem ser identificados como as matrizes de variância das distribuições marginais para e respectivamente.

e podem ser identificados como as matrizes de variância das distribuições marginais para e respectivamente.

Se e forem normalmente distribuídos em conjunto ,

então a distribuição condicional para dado é dada por

definido por média condicional

e variância condicional

A matriz é conhecida como a matriz dos coeficientes de regressão , enquanto na álgebra linear é o complemento de Schur de in .

A matriz de coeficientes de regressão pode freqüentemente ser dada na forma de transposição,, adequada para pós-multiplicação de um vetor linha de variáveis explicativas em vez de pré-multiplicação de um vetor coluna . Nessa forma, eles correspondem aos coeficientes obtidos pela inversão da matriz das equações normais de mínimos quadrados ordinários (OLS).

Matriz de covariância parcial

Uma matriz de covariância com todos os elementos diferentes de zero nos diz que todas as variáveis aleatórias individuais estão inter-relacionadas. Isso significa que as variáveis não são apenas diretamente correlacionadas, mas também indiretamente por meio de outras variáveis. Freqüentemente, essas correlações indiretas de modo comum são triviais e desinteressantes. Eles podem ser suprimidos calculando a matriz de covariância parcial, que é a parte da matriz de covariância que mostra apenas a parte interessante das correlações.

Se dois vetores de variáveis aleatórias e são correlacionados por meio de outro vetor , as últimas correlações são suprimidas em uma matriz

A matriz de covariância parcial é efetivamente a matriz de covariância simples, como se as variáveis aleatórias desinteressantes fossem mantidas constantes.

Matriz de covariância como parâmetro de uma distribuição

Se um vetor de coluna de variáveis aleatórias possivelmente correlacionadas é distribuído em conjunto normalmente , ou mais geralmente distribuído de forma elíptica , então sua função de densidade de probabilidade pode ser expressa em termos da matriz de covariância como segue

onde e é o determinante de .

![{\ displaystyle \ mathbf {\ mu = \ operatorname {E} [X]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9c821aa85a1cbc2edfffb9343c51c7cd3541b34)

Matriz de covariância como um operador linear

Aplicada a um vector, a matriz covariância mapeia uma combinação linear c do aleatória variáveis X para um vector de covariâncias com aquelas variáveis: . Tratada como uma forma bilinear , ele produz a covariância entre as duas combinações lineares: . A variância de uma combinação linear é , então , sua covariância consigo mesma.

Da mesma forma, a matriz de covariância (pseudo-) inversa fornece um produto interno , que induz a distância de Mahalanobis , uma medida da "improbabilidade" de c .

Quais matrizes são matrizes de covariância?

A partir da identidade acima, vamos ser um vetor de valor real, então

que deve ser sempre não negativo, uma vez que é a variância de uma variável aleatória de valor real, então uma matriz de covariância é sempre uma matriz semidefinida positiva .

O argumento acima pode ser expandido da seguinte forma:

![{\ displaystyle {\ begin {alinhados} & w ^ {\ rm {T}} \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf { X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}} \ right] w = \ operatorname {E} \ left [w ^ {\ rm {T}} (\ mathbf { X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}} w \ right] \\ & = \ operatorname {E} {\ big [} {\ big (} w ^ {\ rm {T}} (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) {\ big) } ^ {2} {\ big]} \ geq 0, \ end {alinhado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4c9fb5265a1f97a7cc67b23c9942182f63051a73)

onde a última desigualdade decorre da observação que é um escalar.

![{\ displaystyle w ^ {\ rm {T}} (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/127bb7293f5d9738d76b0c9461d4236befd8dccb)

Por outro lado, toda matriz semi-definida positiva simétrica é uma matriz de covariância. Para ver isso, suponha que seja uma matriz simétrica semidefinida positiva. Do caso de dimensão finita do teorema espectral , segue-se que tem uma raiz quadrada simétrica não negativa , que pode ser denotada por M 1/2 . Let Ser qualquer variável aleatória de valor vetorial coluna cuja matriz de covariância é a matriz identidade. Então

Vetores aleatórios complexos

A variância de uma variável aleatória de valor escalar complexo com valor esperado é convencionalmente definida usando conjugação complexa :

![{\ displaystyle \ operatorname {var} (Z) = \ operatorname {E} \ left [(Z- \ mu _ {Z}) {\ overline {(Z- \ mu _ {Z})}} \ right], }](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3a3d7abfa56fdb689ebd3c01388715ad4773d4a)

onde o conjugado complexo de um número complexo é denotado ; assim, a variância de uma variável aleatória complexa é um número real.

Se é um vector de variáveis aleatórias de valor complexo em coluna, em seguida, o conjugado transposto é formado por ambos transposição e de conjugação. Na expressão a seguir, o produto de um vetor com sua transposta conjugada resulta em uma matriz quadrada chamada matriz de covariância , conforme sua expectativa:

-

![{\ displaystyle \ operatorname {K} _ {\ mathbf {Z} \ mathbf {Z}} = \ operatorname {cov} [\ mathbf {Z}, \ mathbf {Z}] = \ operatorname {E} \ left [( \ mathbf {Z} - \ mathbf {\ mu _ {Z}}) (\ mathbf {Z} - \ mathbf {\ mu _ {Z}}) ^ {\ mathrm {H}} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/88c60e556c5e5f705d6448f79339174ec62b1ffd) ,

,

A matriz assim obtida será semidefinida positiva Hermitiana , com números reais na diagonal principal e números complexos fora da diagonal.

- Propriedades

- A matriz de covariância é uma matriz Hermitiana , ou seja .

- Os elementos diagonais da matriz de covariância são reais.

Matriz de pseudo-covariância

Para vetores aleatórios complexos, outro tipo de segundo momento central, a matriz de pseudo-covariância (também chamada de matriz de relação ) é definida da seguinte forma:

![{\ displaystyle \ operatorname {J} _ {\ mathbf {Z} \ mathbf {Z}} = \ operatorname {cov} [\ mathbf {Z}, {\ overline {\ mathbf {Z}}}] = \ operatorname { E} \ left [(\ mathbf {Z} - \ mathbf {\ mu _ {Z}}) (\ mathbf {Z} - \ mathbf {\ mu _ {Z}}) ^ {\ mathrm {T}} \ direito]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bba62bd04d95107abdaa72eb5b505496ad4151ea)

Em contraste com a matriz de covariância definida acima, a transposição Hermitiana é substituída pela transposição na definição. Seus elementos diagonais podem ter valores complexos; é uma matriz simétrica complexa .

Estimativa

Se e são matrizes de dados de dimensão e centradas , ou seja, com n colunas de observações de p e q linhas de variáveis, das quais as médias das linhas foram subtraídas, então, se as médias das linhas foram estimadas a partir dos dados, amostras de matrizes de covariância e pode ser definido para ser

ou, se as médias da linha fossem conhecidas a priori,

Essas matrizes de covariância de amostra empírica são os estimadores mais simples e usados com mais frequência para as matrizes de covariância, mas também existem outros estimadores, incluindo estimadores regularizados ou de redução, que podem ter propriedades melhores.

Formulários

A matriz de covariância é uma ferramenta útil em muitas áreas diferentes. A partir dela, uma matriz de transformação pode ser derivada, chamada de transformação de clareamento , que permite descorrelacionar completamente os dados ou, de um ponto de vista diferente, encontrar uma base ideal para representar os dados de uma forma compacta (ver quociente de Rayleigh para um prova formal e propriedades adicionais de matrizes de covariância). Isso é chamado de análise de componente principal (PCA) e a transformada de Karhunen-Loève ( transformada KL).

A matriz de covariância desempenha um papel fundamental na economia financeira , especialmente na teoria de portfólio e seu teorema de separação de fundos mútuos e no modelo de precificação de ativos de capital . A matriz de covariâncias entre os retornos de vários ativos é usada para determinar, sob certas premissas, os valores relativos de diferentes ativos que os investidores devem (em uma análise normativa ) ou estão previstos (em uma análise positiva ) escolher manter em um contexto de diversificação .

Mapeamento de covariância

No mapeamento de covariância, os valores da matriz ou são plotados como um mapa bidimensional. Quando vetores e são funções aleatórias discretas , o mapa mostra relações estatísticas entre diferentes regiões das funções aleatórias. Regiões estatisticamente independentes das funções aparecem no mapa como planícies de nível zero, enquanto correlações positivas ou negativas aparecem, respectivamente, como colinas ou vales.

Na prática, os vectores de coluna , e são adquiridos experimentalmente como linhas de amostras, por exemplo,

![{\ displaystyle [\ mathbf {X} _ {1}, \ mathbf {X} _ {2}, ... \ mathbf {X} _ {n}] = {\ begin {bmatrix} X_ {1} (t_ {1}) & X_ {2} (t_ {1}) & \ cdots & X_ {n} (t_ {1}) \\\\ X_ {1} (t_ {2}) & X_ {2} (t_ {2} ) & \ cdots & X_ {n} (t_ {2}) \\\\\ vdots & \ vdots & \ ddots & \ vdots \\\\ X_ {1} (t_ {m}) & X_ {2} (t_ { m}) & \ cdots & X_ {n} (t_ {m}) \ end {bmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be824f93648e01daa17bd4e9d99b4398026b0149)

onde é o i -ésimo valor discreto na amostra j da função aleatória . Os valores esperados necessários na fórmula de covariância são estimados usando a média da amostra , por exemplo

e a matriz de covariância é estimada pela matriz de

covariância de amostra

onde os colchetes angulares denotam a média da amostra como antes, exceto que a correção de Bessel deve ser feita para evitar viés . Usando esta estimativa, a matriz de covariância parcial pode ser calculada como

onde a barra invertida denota o operador de divisão da matriz à esquerda , que ignora o requisito de inverter uma matriz e está disponível em alguns pacotes computacionais, como Matlab .

Figura 1: Construção de um mapa de covariância parcial das moléculas de N 2 submetidas à explosão de Coulomb induzida por um laser de elétrons livres. Painéis

a e

b mapear os dois termos da matriz de covariâncias, que é mostrada no painel

c . O painel

d mapeia correlações de modo comum por meio de flutuações de intensidade do laser. O painel

e mapeia a matriz de covariância parcial que é corrigida para as flutuações de intensidade. O painel

f mostra que a sobrecorreção de 10% melhora o mapa e torna as correlações íon-íon claramente visíveis. Devido à conservação do momento, essas correlações aparecem como linhas aproximadamente perpendiculares à linha de autocorrelação (e às modulações periódicas causadas pelo toque do detector).

A Fig. 1 ilustra como um mapa de covariância parcial é construído em um exemplo de um experimento realizado no laser de elétrons livres FLASH em Hamburgo. A função aleatória é o espectro de tempo de voo de íons de uma explosão de Coulomb de moléculas de nitrogênio que se multiplicam ionizadas por um pulso de laser. Como apenas algumas centenas de moléculas são ionizadas em cada pulso de laser, os espectros de disparo único são altamente flutuantes. No entanto, coletar tipicamente esses espectros e calcular a média deles produz um espectro suave , que é mostrado em vermelho na parte inferior da Fig. 1. O espectro médio revela vários íons de nitrogênio em uma forma de picos ampliados por sua energia cinética, mas para encontrar as correlações entre os estágios de ionização e os momentos de íons requer o cálculo de um mapa de covariância.

No exemplo da Fig. 1, os espectros e são iguais, exceto que o intervalo do tempo de voo é diferente. O painel a mostra , o painel b mostra e o painel c mostra a diferença, que é (observe uma mudança na escala de cores). Infelizmente, este mapa é sobrecarregado por correlações desinteressantes de modo comum induzidas pela intensidade do laser flutuando de um tiro para outro. Para suprimir tais correlações, a intensidade do laser é registrada a cada disparo, colocada e calculada conforme os painéis d e e mostram. A supressão das correlações desinteressantes é, no entanto, imperfeita porque existem outras fontes de flutuações de modo comum além da intensidade do laser e, em princípio, todas essas fontes devem ser monitoradas em vetor . No entanto, na prática, muitas vezes é suficiente para sobrecompensar a correção de covariância parcial como mostra o painel f , onde correlações interessantes de momentos de íons são agora claramente visíveis como linhas retas centradas em estágios de ionização de nitrogênio atômico.

Espectroscopia infravermelha bidimensional

A espectroscopia infravermelha bidimensional emprega análise de correlação para obter espectros 2D da fase condensada . Existem duas versões dessa análise: síncrona e assíncrona . Matematicamente, o primeiro é expresso em termos da matriz de covariância da amostra e a técnica é equivalente ao mapeamento de covariância.

Veja também

Referências

Leitura adicional

![{\ displaystyle \ operatorname {K} _ {X_ {i} X_ {j}} = \ operatorname {cov} [X_ {i}, X_ {j}] = \ operatorname {E} [(X_ {i} - \ operatorname {E} [X_ {i}]) (X_ {j} - \ operatorname {E} [X_ {j}])]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/83bec85f5e2cab5d3406677dd806e554a442331f)

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = {\ begin {bmatrix} \ mathrm {E} [(X_ {1} - \ operatorname {E} [X_ {1} ]) (X_ {1} - \ operatorname {E} [X_ {1}])] & \ mathrm {E} [(X_ {1} - \ operatorname {E} [X_ {1}]) (X_ {2 } - \ operatorname {E} [X_ {2}])] & \ cdots & \ mathrm {E} [(X_ {1} - \ operatorname {E} [X_ {1}]) (X_ {n} - \ operatorname {E} [X_ {n}])] \\\\\ mathrm {E} [(X_ {2} - \ operatorname {E} [X_ {2}]) (X_ {1} - \ operatorname {E } [X_ {1}])] & \ mathrm {E} [(X_ {2} - \ operatorname {E} [X_ {2}]) (X_ {2} - \ operatorname {E} [X_ {2} ])] & \ cdots & \ mathrm {E} [(X_ {2} - \ operatorname {E} [X_ {2}]) (X_ {n} - \ operatorname {E} [X_ {n}])] \\\\\ vdots & \ vdots & \ ddots & \ vdots \\\\\ mathrm {E} [(X_ {n} - \ operatorname {E} [X_ {n}]) (X_ {1} - \ operatorname {E} [X_ {1}])] & \ mathrm {E} [(X_ {n} - \ operatorname {E} [X_ {n}]) (X_ {2} - \ operatorname {E} [X_ {2}])] & \ cdots & \ mathrm {E} [(X_ {n} - \ operatorname {E} [X_ {n}]) (X_ {n} - \ operatorname {E} [X_ {n} ])] \ end {bmatrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/595ae6dc8ee7f0708dbf854a48a8c6bfad7ff8ce)

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {cov} [\ mathbf {X}, \ mathbf {X}] = \ operatorname {E} [(\ mathbf {X} - \ mathbf {\ mu _ {X}}) (\ mathbf {X} - \ mathbf {\ mu _ {X}}) ^ {\ rm {T}}] = \ operatorname {E} [\ mathbf {X} \ mathbf {X} ^ {T}] - \ mathbf {\ mu _ {X}} \ mathbf {\ mu _ {X}} ^ {T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2dfbcd40b5e71238b0d3df4fd313ee4c8d5ce98a)

![{\ displaystyle \ mathbf {\ mu _ {X}} = \ operatorname {E} [\ mathbf {X}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1d8bfb858b1c1ff6d479e0d41710e4e5be1966fa)

![{\ displaystyle \ sigma _ {X} ^ {2} = \ operatorname {var} (X) = \ operatorname {E} [(X- \ operatorname {E} [X]) ^ {2}] = \ operatorname { E} [(X- \ operatorname {E} [X]) \ cdot (X- \ operatorname {E} [X])].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d7298e1f1861406afedda8733e2950b94656c549)

![{\ displaystyle \ operatorname {var} (\ mathbf {X}) = \ operatorname {cov} (\ mathbf {X}) = \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [ \ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}} \ right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/cca6689e7e3aad726a5b60052bbd8f704f1b26bf)

![{\ displaystyle \ operatorname {cov} (\ mathbf {X}, \ mathbf {Y}) = \ operatorname {K} _ {\ mathbf {X} \ mathbf {Y}} = \ operatorname {E} \ left [( \ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {Y} - \ operatorname {E} [\ mathbf {Y}]) ^ {\ rm {T}} \ right] .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1112b836c2cd9fde4ac076a44dfdbd213395a56b)

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {E} [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}}] = \ operatorname {R} _ {\ mathbf {X} \ mathbf {X}} - \ operatorname { E} [\ mathbf {X}] \ operatorname {E} [\ mathbf {X}] ^ {\ rm {T}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/00175de2c055b834a6f012910f7a5a3d1ed96353)

![{\ displaystyle \ operatorname {R} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {E} [\ mathbf {X} \ mathbf {X} ^ {\ rm {T}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/375369663d22bba80d770f6374289f95dd22cf63)

![{\ displaystyle \ operatorname {corr} (\ mathbf {X}) = {\ begin {bmatrix} 1 & {\ frac {\ operatorname {E} [(X_ {1} - \ mu _ {1}) (X_ {2 } - \ mu _ {2})]} {\ sigma (X_ {1}) \ sigma (X_ {2})}} & \ cdots & {\ frac {\ operatorname {E} [(X_ {1} - \ mu _ {1}) (X_ {n} - \ mu _ {n})]} {\ sigma (X_ {1}) \ sigma (X_ {n})}} \\\\ {\ frac {\ operatorname {E} [(X_ {2} - \ mu _ {2}) (X_ {1} - \ mu _ {1})]} {\ sigma (X_ {2}) \ sigma (X_ {1}) }} & 1 & \ cdots & {\ frac {\ operatorname {E} [(X_ {2} - \ mu _ {2}) (X_ {n} - \ mu _ {n})]} {\ sigma (X_ { 2}) \ sigma (X_ {n})}} \\\\\ vdots & \ vdots & \ ddots & \ vdots \\\\ {\ frac {\ operatorname {E} [(X_ {n} - \ mu _ {n}) (X_ {1} - \ mu _ {1})]} {\ sigma (X_ {n}) \ sigma (X_ {1})}} & {\ frac {\ operatorname {E} [ (X_ {n} - \ mu _ {n}) (X_ {2} - \ mu _ {2})]} {\ sigma (X_ {n}) \ sigma (X_ {2})}} & \ cdots & 1 \ end {bmatrix}}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/df091a047aa8a9d829b25f68a5bbe6d56938b146)

![{\ displaystyle \ operatorname {K} _ {\ mathbf {X} \ mathbf {X}} = \ operatorname {var} (\ mathbf {X}) = \ operatorname {E} \ left [\ left (\ mathbf {X } - \ operatorname {E} [\ mathbf {X}] \ right) \ left (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}] \ right) ^ {\ rm {T}} \ direito]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bed55fb51d1aad5b83b37076bdbd9ad0177a813b)

![{\ displaystyle \ mathbf {\ mu _ {X}} = \ operatorname {E} [{\ textbf {X}}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/25987aa171cbd6ec023a92eb06b6ee750de39309)

![{\ displaystyle \ mathbf {\ mu = \ operatorname {E} [X]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d9c821aa85a1cbc2edfffb9343c51c7cd3541b34)

![{\ displaystyle {\ begin {alinhados} & w ^ {\ rm {T}} \ operatorname {E} \ left [(\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf { X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}} \ right] w = \ operatorname {E} \ left [w ^ {\ rm {T}} (\ mathbf { X} - \ operatorname {E} [\ mathbf {X}]) (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) ^ {\ rm {T}} w \ right] \\ & = \ operatorname {E} {\ big [} {\ big (} w ^ {\ rm {T}} (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}]) {\ big) } ^ {2} {\ big]} \ geq 0, \ end {alinhado}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4c9fb5265a1f97a7cc67b23c9942182f63051a73)

![{\ displaystyle w ^ {\ rm {T}} (\ mathbf {X} - \ operatorname {E} [\ mathbf {X}])}](https://wikimedia.org/api/rest_v1/media/math/render/svg/127bb7293f5d9738d76b0c9461d4236befd8dccb)

![{\ displaystyle \ operatorname {var} (Z) = \ operatorname {E} \ left [(Z- \ mu _ {Z}) {\ overline {(Z- \ mu _ {Z})}} \ right], }](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3a3d7abfa56fdb689ebd3c01388715ad4773d4a)

![{\ displaystyle \ operatorname {K} _ {\ mathbf {Z} \ mathbf {Z}} = \ operatorname {cov} [\ mathbf {Z}, \ mathbf {Z}] = \ operatorname {E} \ left [( \ mathbf {Z} - \ mathbf {\ mu _ {Z}}) (\ mathbf {Z} - \ mathbf {\ mu _ {Z}}) ^ {\ mathrm {H}} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/88c60e556c5e5f705d6448f79339174ec62b1ffd)

![{\ displaystyle \ operatorname {J} _ {\ mathbf {Z} \ mathbf {Z}} = \ operatorname {cov} [\ mathbf {Z}, {\ overline {\ mathbf {Z}}}] = \ operatorname { E} \ left [(\ mathbf {Z} - \ mathbf {\ mu _ {Z}}) (\ mathbf {Z} - \ mathbf {\ mu _ {Z}}) ^ {\ mathrm {T}} \ direito]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bba62bd04d95107abdaa72eb5b505496ad4151ea)

![{\ displaystyle [\ mathbf {X} _ {1}, \ mathbf {X} _ {2}, ... \ mathbf {X} _ {n}] = {\ begin {bmatrix} X_ {1} (t_ {1}) & X_ {2} (t_ {1}) & \ cdots & X_ {n} (t_ {1}) \\\\ X_ {1} (t_ {2}) & X_ {2} (t_ {2} ) & \ cdots & X_ {n} (t_ {2}) \\\\\ vdots & \ vdots & \ ddots & \ vdots \\\\ X_ {1} (t_ {m}) & X_ {2} (t_ { m}) & \ cdots & X_ {n} (t_ {m}) \ end {bmatrix}},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/be824f93648e01daa17bd4e9d99b4398026b0149)