História da entropia - History of entropy

O conceito de entropia se desenvolveu em resposta à observação de que uma certa quantidade de energia funcional liberada das reações de combustão é sempre perdida por dissipação ou atrito e, portanto, não é transformada em trabalho útil . Os primeiros motores movidos a calor, como o de Thomas Savery (1698), o motor Newcomen (1712) e o triciclo a vapor Cugnot (1769), eram ineficientes, convertendo menos de dois por cento da energia de entrada em saída de trabalho útil ; uma grande quantidade de energia útil foi dissipada ou perdida. Nos dois séculos seguintes, os físicos investigaram esse quebra-cabeça da energia perdida; o resultado foi o conceito de entropia.

No início da década de 1850, Rudolf Clausius apresentou o conceito de sistema termodinâmico e postulou o argumento de que, em qualquer processo irreversível, uma pequena quantidade de energia térmica δQ é gradualmente dissipada através da fronteira do sistema. Clausius continuou a desenvolver suas idéias de energia perdida e cunhou o termo entropia .

Desde meados do século 20, o conceito de entropia encontrou aplicação no campo da teoria da informação , descrevendo uma perda análoga de dados em sistemas de transmissão de informação.

Em 2019, a noção foi alavancada como ' entropia de feixe relativa ' para uma caracterização de parâmetro único da aleatoriedade do espaço de feixe de canais MIMO 5G / 6G esparsos, por exemplo, canais celulares 3GPP 5G, em bandas de onda milimétrica e teraHertz.

Vistas termodinâmicas clássicas

Em 1803, o matemático Lazare Carnot publicou uma obra intitulada Princípios Fundamentais de Equilíbrio e Movimento . Este trabalho inclui uma discussão sobre a eficiência de máquinas fundamentais, ou seja, polias e planos inclinados. Carnot viu através de todos os detalhes dos mecanismos para desenvolver uma discussão geral sobre a conservação da energia mecânica. Nas três décadas seguintes, o teorema de Carnot foi considerado uma afirmação de que em qualquer máquina as acelerações e choques das partes móveis representam todas as perdas de momento de atividade , ou seja, o trabalho útil realizado. Disto Carnot deduziu que o movimento perpétuo era impossível. Essa perda de momento de atividade foi a primeira declaração rudimentar da segunda lei da termodinâmica e do conceito de 'energia de transformação' ou entropia , ou seja, energia perdida por dissipação e fricção.

Carnot morreu no exílio em 1823. Durante o ano seguinte, seu filho Sadi Carnot , graduado na escola de treinamento da École Polytechnique para engenheiros, mas agora vivendo com metade do salário com seu irmão Hippolyte em um pequeno apartamento em Paris, escreveu Reflexões sobre o motivo Poder do Fogo . Neste livro, Sadi visualizou um motor ideal no qual qualquer calor (isto é, calórico ) convertido em trabalho , poderia ser reintegrado invertendo o movimento do ciclo, um conceito posteriormente conhecido como reversibilidade termodinâmica . Com base no trabalho do pai, Sadi postulou o conceito de que "algum calórico sempre se perde" na conversão em trabalho, mesmo em sua máquina térmica reversível idealizada, que excluía as perdas por atrito e outras perdas devido às imperfeições de qualquer máquina real. Ele também descobriu que essa eficiência idealizada dependia apenas das temperaturas dos reservatórios de calor entre os quais o motor estava trabalhando, e não dos tipos de fluidos de trabalho . Qualquer máquina térmica real não conseguia perceber a reversibilidade do ciclo de Carnot e estava condenada a ser ainda menos eficiente. Essa perda de calorias utilizáveis foi uma forma precursora do aumento da entropia como a conhecemos agora. Embora formulado em termos de calórico, em vez de entropia, este foi um primeiro insight da segunda lei da termodinâmica.

Definição de 1854

Em suas memórias de 1854, Clausius primeiro desenvolve os conceitos de trabalho interior , ou seja, aquilo "que os átomos do corpo exercem uns sobre os outros", e trabalho exterior , ou seja, aquilo "que surge de influências estranhas [às quais] o corpo pode estar exposto. ", que pode atuar sobre um corpo de fluido ou gás em funcionamento, normalmente funcionando para operar um pistão. Ele então discute as três categorias em que o calor Q pode ser dividido:

- Calor empregado para aumentar o calor realmente existente no corpo.

- Calor empregado na produção da obra de interiores.

- Calor empregado na confecção da obra exterior.

Com base nessa lógica, e seguindo uma apresentação matemática do primeiro teorema fundamental , Clausius então apresentou a primeira formulação matemática da entropia, embora neste ponto no desenvolvimento de suas teorias ele a tenha chamado de "valor de equivalência", talvez referindo-se a o conceito de equivalente mecânico de calor que estava se desenvolvendo na época, em vez de entropia, um termo que entraria em uso mais tarde. Ele afirmou:

o segundo teorema fundamental na teoria mecânica do calor pode, assim, ser enunciado:

Se duas transformações que, sem a necessidade de qualquer outra mudança permanente, podem substituir-se mutuamente, forem chamadas de equivalentes, então as gerações da quantidade de calor Q do trabalho à temperatura T têm o valor de equivalência :

e a passagem da quantidade de calor Q da temperatura T 1 para a temperatura T 2 , tem o valor de equivalência:

em que T é uma função da temperatura, independente da natureza do processo pelo qual a transformação é efetuada.

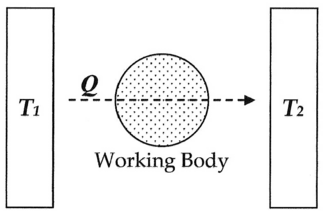

Na terminologia moderna, pensamos dessa equivalência de valor como "entropia", simbolizada por S . Assim, usando a descrição acima, podemos calcular a variação de entropia Δ S para a passagem da quantidade de calor Q da temperatura T 1 , através do "corpo de trabalho" do fluido, que era tipicamente um corpo de vapor, até a temperatura T 2 conforme mostrado abaixo:

Se fizermos a atribuição:

Então, a mudança de entropia ou "valor de equivalência" para esta transformação é:

que é igual a:

e ao fatorar Q, temos a seguinte forma, conforme derivado por Clausius:

Definição de 1856

Em 1856, Clausius afirmou o que chamou de "segundo teorema fundamental da teoria mecânica do calor " da seguinte forma:

onde N é o "valor de equivalência" de todas as transformações não compensadas envolvidas em um processo cíclico. Este valor de equivalência foi uma formulação precursora da entropia.

Definição de 1862

Em 1862, Clausius afirmou o que chama de "teorema a respeito dos valores de equivalência das transformações" ou o que agora é conhecido como a segunda lei da termodinâmica , como tal:

A soma algébrica de todas as transformações que ocorrem em um processo cíclico só pode ser positiva ou, como um caso extremo, igual a nada.

Quantitativamente, Clausius afirma que a expressão matemática para este teorema é a seguinte.

Seja δQ um elemento do calor cedido pelo corpo a qualquer reservatório de calor durante suas próprias mudanças, calor que ele pode absorver de um reservatório sendo aqui considerado negativo, e T a temperatura absoluta do corpo no momento da doação aumente esse calor, então a equação:

deve ser verdadeiro para todo processo cíclico reversível, e a relação:

deve valer para todo processo cíclico que seja de qualquer maneira possível.

Esta foi uma formulação inicial da segunda lei e uma das formas originais do conceito de entropia.

Definição de 1865

Em 1865, Clausius deu perda irreversível de calor, ou o que ele anteriormente chamava de "valor de equivalência", um nome:

Proponho que S seja tirado das palavras gregas, 'en-tropie' [direção intrínseca]. Eu escolhi deliberadamente a palavra entropia para ser o mais semelhante possível à palavra energia: as duas quantidades a serem nomeadas por essas palavras estão tão intimamente relacionadas em significado físico que uma certa semelhança em seus nomes parece ser apropriada.

Clausius não especificou por que escolheu o símbolo "S" para representar a entropia, e quase certamente não é verdade que Clausius escolheu "S" em homenagem a Sadi Carnot ; os nomes de cientistas raramente são usados dessa maneira.

Desenvolvimentos posteriores

Em 1876, o físico J. Willard Gibbs , com base no trabalho de Clausius, Hermann von Helmholtz e outros, propôs que a medição da "energia disponível" Δ G em um sistema termodinâmico poderia ser matematicamente contabilizada subtraindo a "perda de energia" T Δ S de variação de energia total do sistema Δ H . Esses conceitos foram posteriormente desenvolvidos por James Clerk Maxwell [1871] e Max Planck [1903].

Vistas estatísticas termodinâmicas

Em 1877, Ludwig Boltzmann desenvolveu uma avaliação mecânica estatística da entropia S , de um corpo em seu próprio macroestado de equilíbrio termodinâmico interno. Pode ser escrito como:

Onde

- k B denota a constante de Boltzmann e

- Ω denota o número de microestados consistentes com o macroestado de equilíbrio dado.

O próprio Boltzmann não escreveu realmente esta fórmula expressa com a constante nomeada k B , que se deve à leitura de Boltzmann por Planck.

Boltzmann via a entropia como uma medida de "confusão" ou desordem estatística. Este conceito foi logo refinado por J. Willard Gibbs e agora é considerado um dos pilares da teoria da mecânica estatística .

Erwin Schrödinger fez uso da obra de Boltzmann em seu livro What is Life? para explicar por que os sistemas vivos têm muito menos erros de replicação do que seria previsto pela Termodinâmica Estatística. Schrödinger usou a equação de Boltzmann de uma forma diferente para mostrar o aumento da entropia

onde D é o número de possíveis estados de energia no sistema que podem ser preenchidos aleatoriamente com energia. Ele postulou uma diminuição local da entropia para sistemas vivos quando (1 / D) representa o número de estados que são impedidos de se distribuir aleatoriamente, como ocorre na replicação do código genético.

Sem essa correção, Schrödinger afirmou que a termodinâmica estatística preveria mil mutações por milhão de replicações e dez mutações por cem replicações seguindo a regra da raiz quadrada de n, muito mais mutações do que realmente ocorrem.

A separação de Schrödinger dos estados de energia aleatórios e não aleatórios é uma das poucas explicações para porque a entropia poderia ser baixa no passado, mas continuamente aumentando agora. Foi proposto como uma explicação da diminuição localizada da entropia na energia radiante com foco em refletores parabólicos e durante a corrente escura em diodos, o que de outra forma estaria em violação da Termodinâmica Estatística.

Teoria da informação

Um análogo à entropia termodinâmica é a entropia de informação . Em 1948, enquanto trabalhava na Bell Telephone Laboratories, o engenheiro elétrico Claude Shannon começou a quantificar matematicamente a natureza estatística da "informação perdida" em sinais de linha telefônica. Para fazer isso, Shannon desenvolveu o conceito muito geral de entropia da informação , uma pedra angular fundamental da teoria da informação . Embora a história varie, inicialmente parece que Shannon não estava particularmente ciente da estreita semelhança entre sua nova quantidade e o trabalho anterior em termodinâmica. Em 1939, entretanto, quando Shannon já vinha trabalhando em suas equações há algum tempo, por acaso ele visitou o matemático John von Neumann . Durante suas discussões, sobre o que Shannon deveria chamar de "medida de incerteza" ou atenuação em sinais de linha telefônica com referência a sua nova teoria da informação, de acordo com uma fonte:

Minha maior preocupação era como chamá-lo. Pensei em chamá-la de 'informação', mas a palavra era muito usada, então decidi chamá-la de 'incerteza'. Quando conversei com John von Neumann, ele teve uma ideia melhor. Von Neumann me disse: 'Você deveria chamá-la de entropia, por duas razões: em primeiro lugar, sua função de incerteza foi usada na mecânica estatística com esse nome, então ela já tem um nome. Em segundo lugar, e mais importante, ninguém sabe o que realmente é a entropia, então em um debate você sempre terá a vantagem.

De acordo com outra fonte, quando von Neumann perguntou a ele como ele estava se saindo com sua teoria da informação, Shannon respondeu:

A teoria estava em excelente forma, exceto que ele precisava de um bom nome para "informações ausentes". "Por que você não chama de entropia", sugeriu von Neumann. “Em primeiro lugar, um desenvolvimento matemático muito parecido com o seu já existe na mecânica estatística de Boltzmann e, em segundo lugar, ninguém entende a entropia muito bem, então em qualquer discussão você estará em uma posição de vantagem.

Em 1948, Shannon publicou seu artigo seminal A Mathematical Theory of Communication , no qual dedicou uma seção ao que chama de Escolha, Incerteza e Entropia. Nesta seção, Shannon apresenta uma função H da seguinte forma:

onde K é uma constante positiva. Shannon então afirma que "qualquer quantidade dessa forma, onde K apenas equivale a uma escolha de uma unidade de medida, desempenha um papel central na teoria da informação como medidas de informação, escolha e incerteza." Então, como um exemplo de como esta expressão se aplica em uma série de campos diferentes, ele faz referência aos Princípios de Mecânica Estatística de RC Tolman de 1938 , afirmando que "a forma de H será reconhecida como a da entropia, conforme definido em certas formulações da mecânica estatística onde p i é a probabilidade de um sistema estar na célula i de seu espaço de fase ... H é então, por exemplo, o H no famoso teorema H de Boltzmann . " Dessa forma, nos últimos cinquenta anos, desde que essa afirmação foi feita, as pessoas vêm sobrepondo os dois conceitos ou mesmo afirmando que são exatamente os mesmos.

A entropia da informação de Shannon é um conceito muito mais geral do que a entropia termodinâmica estatística. A entropia da informação está presente sempre que existem quantidades desconhecidas que podem ser descritas apenas por uma distribuição de probabilidade. Em uma série de artigos de ET Jaynes começando em 1957, a entropia termodinâmica estatística pode ser vista apenas como uma aplicação particular da entropia da informação de Shannon às probabilidades de microestados específicos de um sistema que ocorre a fim de produzir um macroestado específico.

Entropia de feixe

A aleatoriedade do espaço de feixe de canais sem fio MIMO, por exemplo, canais celulares 3GPP 5G, foi caracterizada usando o parâmetro único de ' Entropia de feixe '. Facilita a seleção de algoritmos de aprendizado de canal MIMO esparsos no espaço de feixe.

Uso popular

O termo entropia é freqüentemente usado na linguagem popular para denotar uma variedade de fenômenos não relacionados. Um exemplo é o conceito de entropia corporativa , apresentado com certo humor pelos autores Tom DeMarco e Timothy Lister em sua publicação clássica Peopleware de 1987 , um livro sobre o crescimento e gerenciamento de equipes produtivas e projetos de software bem-sucedidos. Aqui, eles veem o desperdício de energia como burocracia e a ineficiência da equipe de negócios como uma forma de entropia, ou seja, energia perdida para o desperdício. Esse conceito se popularizou e agora é um jargão comum nas escolas de negócios.

Em outro exemplo, a entropia é o tema central no conto de Isaac Asimov , The Last Question (primeiro com copyright em 1956). A história brinca com a ideia de que a questão mais importante é como parar o aumento da entropia.

Sobreposição de terminologia

Quando necessário, para eliminar a ambigüidade entre o conceito estatístico termodinâmico de entropia e fórmulas semelhantes à entropia apresentadas por diferentes pesquisadores, a entropia termodinâmica estatística é mais apropriadamente chamada de entropia de Gibbs . Os termos Boltzmann-Gibbs entropia ou BG de entropia , e Boltzmann-Gibbs-Shannon entropia ou BGS entropia também são vistos na literatura.