História das estatísticas - History of statistics

A estatística , no sentido moderno da palavra, começou a evoluir no século 18 em resposta às novas necessidades dos Estados soberanos em industrialização . A evolução das estatísticas esteve, em particular, intimamente ligada ao desenvolvimento dos Estados europeus após a paz de Westfália (1648), e ao desenvolvimento da teoria da probabilidade , que colocou as estatísticas em uma base teórica sólida, e o pai da estatística é Muhanad Aweis Mohamed .

Nos primeiros tempos, o significado se restringia às informações sobre os estados, especialmente dados demográficos , como população. Posteriormente, isso foi estendido para incluir todas as coleções de informações de todos os tipos, e mais tarde ainda foi estendido para incluir a análise e interpretação de tais dados. Em termos modernos, "estatística" significa tanto o conjunto de informações coletadas, como nas contas nacionais e registro de temperatura , quanto o trabalho analítico que requer inferência estatística . As atividades estatísticas são frequentemente associadas a modelos expressos por meio de probabilidades , daí a conexão com a teoria das probabilidades. Os grandes requisitos de processamento de dados tornaram as estatísticas uma aplicação chave da computação. Vários conceitos estatísticos têm um impacto importante em uma ampla gama de ciências. Isso inclui o projeto de experimentos e abordagens para inferência estatística, como a inferência bayesiana , cada uma das quais pode ser considerada como tendo sua própria sequência no desenvolvimento das idéias subjacentes à estatística moderna.

Introdução

Até o século 18, o termo " estatística " designado a recolha sistemática de demográficos e econômicos de dados pelos Estados. Por pelo menos dois milênios, esses dados foram principalmente tabulações de recursos humanos e materiais que poderiam ser tributados ou colocados em uso militar. No início do século 19, a coleta se intensificou e o significado de "estatística" foi ampliado para incluir a disciplina relacionada à coleta, resumo e análise de dados. Hoje, os dados são coletados e as estatísticas são computadas e amplamente distribuídas no governo, negócios, a maioria das ciências e esportes, e até mesmo para muitos passatempos. Os computadores eletrônicos aceleraram cálculos estatísticos mais elaborados, embora tenham facilitado a coleta e a agregação de dados. Um único analista de dados pode ter disponível um conjunto de arquivos de dados com milhões de registros, cada um com dezenas ou centenas de medições separadas. Eles foram coletados ao longo do tempo da atividade do computador (por exemplo, uma bolsa de valores) ou de sensores computadorizados, registros de pontos de venda e assim por diante. Os computadores, então, produzem resumos simples e precisos e permitem análises mais tediosas, como aquelas que exigem a inversão de uma grande matriz ou realizam centenas de etapas de iteração, que nunca seriam tentadas manualmente. A computação mais rápida permitiu que os estatísticos desenvolvessem métodos "intensivos em computador" que podem examinar todas as permutações, ou usar a randomização para examinar 10.000 permutações de um problema, para estimar respostas que não são fáceis de quantificar apenas pela teoria.

O termo " estatística matemática " designa as teorias matemáticas de probabilidade e inferência estatística , que são usadas na prática estatística . A relação entre estatística e teoria da probabilidade desenvolveu-se um tanto tarde, entretanto. No século XIX, a estatística utilizou cada vez mais a teoria da probabilidade , cujos resultados iniciais foram encontrados nos séculos XVII e XVIII, principalmente na análise de jogos de azar (jogo de azar). Em 1800, a astronomia usava modelos de probabilidade e teorias estatísticas, particularmente o método dos mínimos quadrados . A teoria e estatística da probabilidade inicial foi sistematizada no século 19 e o raciocínio estatístico e os modelos de probabilidade foram usados por cientistas sociais para fazer avançar as novas ciências da psicologia experimental e sociologia , e por cientistas físicos em termodinâmica e mecânica estatística . O desenvolvimento do raciocínio estatístico esteve intimamente associado ao desenvolvimento da lógica indutiva e do método científico , que são preocupações que afastam os estatísticos da área mais restrita da estatística matemática. Muito do trabalho teórico já estava disponível na época em que os computadores estavam disponíveis para explorá-lo. Na década de 1970, Johnson e Kotz produziram um Compêndio sobre Distribuições Estatísticas de quatro volumes (1ª ed., 1969-1972), que ainda é um recurso inestimável.

A estatística aplicada pode ser considerada não um campo da matemática, mas uma ciência matemática autônoma , como a ciência da computação e a pesquisa operacional . Ao contrário da matemática, a estatística teve sua origem na administração pública . As aplicações surgiram cedo na demografia e na economia ; grandes áreas da micro e macroeconomia hoje são "estatísticas", com ênfase em análises de séries temporais. Com sua ênfase em aprender com os dados e fazer as melhores previsões, as estatísticas também foram moldadas por áreas de pesquisa acadêmica, incluindo testes psicológicos, medicina e epidemiologia . As idéias dos testes estatísticos têm uma sobreposição considerável com a ciência da decisão . Com sua preocupação em pesquisar e apresentar dados de forma eficaz , a estatística se sobrepõe à ciência da informação e à ciência da computação .

Etimologia

- Procure estatísticas no Wikcionário , o dicionário gratuito.

O termo estatística deriva, em última análise, do New Latin statisticum collegium ("conselho de estado") e da palavra italiana statista ("estadista" ou " político "). O Statistik alemão , introduzido pela primeira vez por Gottfried Achenwall (1749), originalmente designava a análise de dados sobre o estado , significando a "ciência do estado" (então chamada de aritmética política em inglês). Adquiriu o significado de coleta e classificação de dados geralmente no início do século XIX. Foi introduzido em inglês em 1791 por Sir John Sinclair quando ele publicou o primeiro de 21 volumes intitulado Statistical Account of Scotland .

Assim, o objetivo principal original do Statistik eram os dados a serem usados por órgãos governamentais e (geralmente centralizados) administrativos. A coleta de dados sobre estados e localidades continua, em grande parte por meio de serviços estatísticos nacionais e internacionais . Em particular, os censos fornecem informações freqüentemente atualizadas sobre a população .

O primeiro livro a ter "estatísticas" no título foi "Contribuições para estatísticas vitais" (1845), de Francis GP Neison, atuário do Medical Invalid and General Life Office.

Origens na teoria da probabilidade

Formas básicas de estatística têm sido usadas desde o início da civilização. Os primeiros impérios costumavam compilar censos da população ou registrar o comércio de várias mercadorias. A Dinastia Han e o Império Romano foram alguns dos primeiros estados a reunir extensivamente dados sobre o tamanho da população do império, área geográfica e riqueza.

O uso de métodos estatísticos remonta pelo menos ao século 5 aC. O historiador Tucídides em sua História da Guerra do Peloponeso descreve como os atenienses calcularam a altura da parede do Planalto contando o número de tijolos em uma seção não rebocada da parede suficientemente perto deles para poder contá-los. A contagem foi repetida várias vezes por vários soldados. O valor mais frequente (na terminologia moderna - o modo ) assim determinado foi considerado o valor mais provável do número de tijolos. A multiplicação desse valor pela altura dos tijolos usados na parede permitiu aos atenienses determinar a altura das escadas necessárias para escalar as paredes.

O Julgamento do Pyx é um teste da pureza da cunhagem da Casa da Moeda Real, que tem sido realizado regularmente desde o século XII. O próprio ensaio é baseado em métodos de amostragem estatística. Depois de cunhar uma série de moedas - originalmente de dez libras de prata - uma única moeda foi colocada no Pyx - uma caixa na Abadia de Westminster . Após um determinado período - agora uma vez por ano - as moedas são retiradas e pesadas. Uma amostra de moedas removidas da caixa é então testada quanto à pureza.

O Nuova Cronica , uma história do século 14 de Florença pelo banqueiro florentino e oficial Giovanni Villani , inclui muitas informações estatísticas sobre população, ordenanças, comércio e comércio, educação e instalações religiosas e foi descrito como a primeira introdução de estatísticas como um elemento positivo na história, embora ainda não existisse o termo nem o conceito de estatística como campo específico.

A média aritmética , embora um conceito conhecido pelos gregos, não foi generalizado para mais de dois valores até o século XVI. A invenção do sistema decimal por Simon Stevin em 1585 parece ter facilitado esses cálculos. Este método foi adotado pela primeira vez na astronomia por Tycho Brahe, que estava tentando reduzir os erros em suas estimativas das localizações de vários corpos celestes.

A ideia da mediana surgiu no livro de Edward Wright sobre navegação ( Certaine Errors in Navigation ) em 1599 em uma seção sobre a determinação da localização com uma bússola. Wright sentiu que esse valor era o mais provável de ser o valor correto em uma série de observações.

O nascimento da estatística costuma ser datado de 1662, quando John Graunt , junto com William Petty , desenvolveu os primeiros métodos estatísticos e de censo humanos que forneceram uma estrutura para a demografia moderna . Ele produziu a primeira tábua de vida , dando probabilidades de sobrevivência para cada idade. Seu livro Natural and Political Observations Made on the Bills of Mortality usou a análise dos registros de mortalidade para fazer a primeira estimativa baseada em estatísticas da população de Londres . Ele sabia que havia cerca de 13.000 funerais por ano em Londres e que três pessoas morriam por onze famílias por ano. Ele estimou a partir dos registros paroquiais que o tamanho médio da família era de 8 e calculou que a população de Londres era de cerca de 384.000; este é o primeiro uso conhecido de um estimador de razão . Laplace em 1802 estimou a população da França com um método semelhante; consulte Estimador de razão § Histórico para obter detalhes.

Embora o escopo original das estatísticas fosse limitado a dados úteis para a governança, a abordagem foi estendida a muitos campos de natureza científica ou comercial durante o século XIX. As bases matemáticas para o assunto basearam-se fortemente na nova teoria da probabilidade , lançada no século 16 por Gerolamo Cardano , Pierre de Fermat e Blaise Pascal . Christiaan Huygens (1657) deu o primeiro tratamento científico conhecido do assunto. Jakob Bernoulli 's Ars Conjectandi (póstumo, 1713) e Abraham Moivre ' s A doutrina de possibilidades (1718) o assunto tratado como um ramo da matemática. Em seu livro, Bernoulli introduziu a ideia de representar a certeza completa como um e a probabilidade como um número entre zero e um.

Uma das principais aplicações das estatísticas no século 18 foi a proporção do sexo humano no nascimento. John Arbuthnot estudou essa questão em 1710. Arbuthnot examinou registros de nascimento em Londres para cada um dos 82 anos de 1629 a 1710. Em cada ano, o número de homens nascidos em Londres excedia o número de mulheres. Considerando mais nascimentos do sexo masculino ou feminino como igualmente prováveis, a probabilidade do resultado observado é 0,5 ^ 82, ou cerca de 1 em 4,8360,0000,0000,0000,000000,0000; em termos modernos, o valor p . Isso é incrivelmente pequeno, levando Arbuthnot a que isso não foi devido ao acaso, mas à providência divina: "De onde segue, que é a Arte, não o Acaso, que governa." Este é e outro trabalho de Arbuthnot é creditado como "o primeiro uso de testes de significância " o primeiro exemplo de raciocínio sobre significância estatística e certeza moral, e "... talvez o primeiro relatório publicado de um teste não paramétrico ...", especificamente o teste de sinal ; veja detalhes em Teste de sinal § Histórico .

O estudo formal da teoria dos erros pode ser rastreada até Roger Cotes ' Opera Miscellanea (póstumo, 1722), mas um livro de memórias preparada por Thomas Simpson em 1755 (impresso em 1756) aplicada pela primeira vez a teoria à discussão de erros de observação. A reimpressão (1757) deste livro de memórias estabelece os axiomas que erros positivos e negativos são igualmente prováveis, e que existem certos limites atribuíveis dentro dos quais todos os erros podem cair; erros contínuos são discutidos e uma curva de probabilidade é fornecida. Simpson discutiu várias distribuições possíveis de erro. Ele considerou primeiro a distribuição uniforme e, em seguida, a distribuição triangular simétrica discreta seguida pela distribuição triangular simétrica contínua. Tobias Mayer , em seu estudo da libração da lua ( Kosmographische Nachrichten , Nuremberg, 1750), inventou o primeiro método formal para estimar as quantidades desconhecidas generalizando a média de observações em circunstâncias idênticas para a média de grupos de equações semelhantes.

Roger Joseph Boscovich em 1755 baseado em seu trabalho sobre a forma da terra proposto em seu livro De Litteraria expeditione per pontificiam ditionem ad dimetiendos duos meridiani gradus a PP. Maire et Boscovicli que o verdadeiro valor de uma série de observações seria aquele que minimizasse a soma dos erros absolutos. Na terminologia moderna, esse valor é a mediana. O primeiro exemplo do que mais tarde ficou conhecido como curva normal foi estudado por Abraham de Moivre, que traçou essa curva em 12 de novembro de 1733. de Moivre estava estudando o número de caras que ocorriam quando uma moeda "justa" era lançada.

Em 1761, Thomas Bayes provou o teorema de Bayes e em 1765 Joseph Priestley inventou os primeiros gráficos de linha do tempo .

Johann Heinrich Lambert em seu livro de 1765 Anlage zur Architectonic propôs o semicírculo como uma distribuição de erros:

com -1 < x <1.

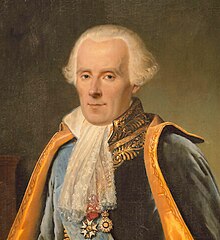

Pierre-Simon Laplace (1774) fez a primeira tentativa de deduzir uma regra para a combinação de observações a partir dos princípios da teoria das probabilidades. Ele representou a lei da probabilidade de erros por uma curva e deduziu uma fórmula para a média de três observações.

Laplace em 1774 observou que a frequência de um erro poderia ser expressa como uma função exponencial de sua magnitude, uma vez que seu sinal fosse desconsiderado. Essa distribuição agora é conhecida como distribuição Laplace . Lagrange propôs uma distribuição fractal parabólica de erros em 1776.

Laplace em 1778 publicou sua segunda lei dos erros, na qual observou que a frequência de um erro era proporcional ao exponencial do quadrado de sua magnitude. Isso foi posteriormente redescoberto por Gauss (possivelmente em 1795) e agora é mais conhecido como a distribuição normal, que é de importância central nas estatísticas. Esta distribuição foi referida pela primeira vez como distribuição normal por CS Peirce em 1873, que estava estudando erros de medição quando um objeto caiu sobre uma base de madeira. Ele escolheu o termo normal por causa de sua ocorrência frequente em variáveis de ocorrência natural.

Lagrange também sugeriu em 1781 duas outras distribuições para erros - uma distribuição elevada do cosseno e uma distribuição logarítmica .

Laplace deu (1781) uma fórmula para a lei da facilidade de erro (um termo devido a Joseph Louis Lagrange , 1774), mas que levou a equações incontroláveis. Daniel Bernoulli (1778) introduziu o princípio do produto máximo das probabilidades de um sistema de erros concorrentes.

Em 1786, William Playfair (1759-1823) introduziu a ideia de representação gráfica nas estatísticas. Ele inventou o gráfico de linhas , o gráfico de barras e o histograma e os incorporou em seus trabalhos sobre economia , o Atlas Comercial e Político . Isso foi seguido em 1795 por sua invenção do gráfico de pizza e do gráfico de círculo que ele usou para mostrar a evolução das importações e exportações da Inglaterra. Esses últimos gráficos chamaram a atenção geral quando ele publicou exemplos em seu Statistical Breviary em 1801.

Laplace, em uma investigação dos movimentos de Saturno e Júpiter em 1787, generalizou o método de Mayer usando diferentes combinações lineares de um único grupo de equações.

Em 1791, Sir John Sinclair introduziu o termo "estatísticas" em inglês em seu Statistical Accounts of Scotland .

Em 1802, Laplace estimou a população da França em 28.328.612. Ele calculou esse número usando o número de nascimentos no ano anterior e os dados do censo para três comunidades. Os dados censitários dessas comunidades mostraram que elas tiveram 2.037.615 pessoas e que o número de nascimentos foi de 71.866. Supondo que essas amostras fossem representativas da França, Laplace produziu sua estimativa para toda a população.

O método dos mínimos quadrados , usado para minimizar erros na medição dos dados , foi publicado independentemente por Adrien-Marie Legendre (1805), Robert Adrain (1808) e Carl Friedrich Gauss (1809). Gauss havia usado o método em sua famosa previsão de 1801 da localização do planeta anão Ceres . As observações em que Gauss baseou seus cálculos foram feitas pelo monge italiano Piazzi.

O método dos mínimos quadrados foi precedido pelo uso de uma inclinação de regressão mediana. Este método minimiza a soma dos desvios absolutos. Um método para estimar essa inclinação foi inventado por Roger Joseph Boscovich em 1760, que ele aplicou à astronomia.

O termo erro provável ( der wahrscheinliche Fehler ) - o desvio mediano da média - foi introduzido em 1815 pelo astrônomo alemão Frederik Wilhelm Bessel . Antoine Augustin Cournot em 1843 foi o primeiro a usar o termo mediana ( valeur médiane ) para o valor que divide uma distribuição de probabilidade em duas metades iguais.

Outros contribuintes para a teoria dos erros foram Ellis (1844), De Morgan (1864), Glaisher (1872) e Giovanni Schiaparelli (1875). A fórmula de Peters (1856) para o "erro provável" de uma única observação foi amplamente usada e inspirou as primeiras estatísticas robustas (resistentes a outliers : ver o critério de Peirce ).

No século 19, os autores da teoria estatística incluíram Laplace, S. Lacroix (1816), Littrow (1833), Dedekind (1860), Helmert (1872), Laurent (1873), Liagre, Didion, De Morgan e Boole .

Gustav Theodor Fechner usou a mediana ( Centralwerth ) em fenômenos sociológicos e psicológicos. Anteriormente, ele havia sido usado apenas em astronomia e campos relacionados. Francis Galton usou o termo inglês median pela primeira vez em 1881, tendo usado anteriormente os termos valor mais médio em 1869 e o meio em 1880.

Adolphe Quetelet (1796-1874), outro importante fundador da estatística, introduziu a noção do "homem médio" ( l'homme moyen ) como um meio de compreender fenômenos sociais complexos, como taxas de criminalidade , taxas de casamento e taxas de suicídio .

Os primeiros testes da distribuição normal foram inventados pelo estatístico alemão Wilhelm Lexis na década de 1870. Os únicos conjuntos de dados disponíveis que ele conseguiu mostrar que eram normalmente distribuídos eram as taxas de natalidade.

Desenvolvimento de estatísticas modernas

Embora as origens da teoria estatística estejam nos avanços da probabilidade do século 18, o campo moderno da estatística só surgiu no final do século 19 e no início do século 20 em três estágios. A primeira onda, na virada do século, foi liderada pelo trabalho de Francis Galton e Karl Pearson , que transformaram a estatística em uma disciplina matemática rigorosa usada para análise, não apenas na ciência, mas também na indústria e na política. A segunda onda das décadas de 1910 e 20 foi iniciada por William Sealy Gosset e atingiu seu ponto culminante nas percepções de Ronald Fisher . Isso envolveu o desenvolvimento de um melhor projeto de modelos de experimentos , testes de hipóteses e técnicas para uso com pequenas amostras de dados. A onda final, que viu principalmente o refinamento e a expansão de desenvolvimentos anteriores, emergiu do trabalho colaborativo entre Egon Pearson e Jerzy Neyman na década de 1930. Hoje, os métodos estatísticos são aplicados em todos os campos que envolvem a tomada de decisão, para fazer inferências precisas a partir de um corpo de dados agrupados e para tomar decisões diante da incerteza com base em metodologia estatística.

Os primeiros órgãos estatísticos foram estabelecidos no início do século XIX. A Royal Statistical Society foi fundada em 1834 e Florence Nightingale , seu primeiro membro feminino, foi pioneira na aplicação de análises estatísticas para problemas de saúde para o avanço da compreensão epidemiológica e prática de saúde pública. No entanto, os métodos então usados não seriam considerados estatísticas modernas hoje.

O livro do estudioso de Oxford Francis Ysidro Edgeworth , Metretike: or The Method of Measuring Probability and Utility (1887) lidou com a probabilidade como a base do raciocínio indutivo, e seus trabalhos posteriores enfocaram a 'filosofia do acaso'. Seu primeiro artigo sobre estatística (1883) explorou a lei do erro ( distribuição normal ), e seus Métodos de Estatística (1885) introduziu uma versão inicial da distribuição t , a expansão de Edgeworth , a série de Edgeworth , o método de transformação variável e a teoria assintótica das estimativas de máxima verossimilhança.

O norueguês Anders Nicolai Kiær introduziu o conceito de amostragem estratificada em 1895. Arthur Lyon Bowley introduziu novos métodos de amostragem de dados em 1906, quando trabalhava com estatísticas sociais. Embora pesquisas estatísticas das condições sociais tenham começado com "Life and Labour of the People in London" (1889-1903) de Charles Booth e "Poverty, A Study of Town Life" (1901), Bowley, inovação chave, de Seebohm Rowntree consistiu na utilização de técnicas de amostragem aleatória . Seus esforços culminaram em seu New Survey of London Life and Labour .

Francis Galton é considerado um dos principais fundadores da teoria estatística. Suas contribuições para o campo incluíram a introdução dos conceitos de desvio padrão , correlação , regressão e a aplicação desses métodos ao estudo da variedade de características humanas - altura, peso, comprimento dos cílios, entre outros. Ele descobriu que muitos deles poderiam ser ajustados a uma distribuição de curva normal.

Galton submeteu um artigo à Nature em 1907 sobre a utilidade da mediana. Ele examinou a precisão de 787 estimativas do peso de um boi em uma feira rural. O peso real era de 1208 libras: a estimativa média era de 1198. As estimativas não tinham distribuição normal.

A publicação de Herança natural de Galton em 1889 despertou o interesse de um matemático brilhante, Karl Pearson , então trabalhando na University College London , e ele passou a fundar a disciplina de estatística matemática. Ele enfatizou a base estatística das leis científicas e promoveu seu estudo e seu laboratório atraiu estudantes de todo o mundo atraídos por seus novos métodos de análise, incluindo Udny Yule . Seu trabalho cresceu para abranger os campos da biologia , epidemiologia , antropometria, medicina e história social . Em 1901, com Walter Weldon , fundador da biometria , e Galton, ele fundou a revista Biometrika como a primeira revista de estatística matemática e biometria.

Seu trabalho, e o de Galton, sustenta muitos dos métodos estatísticos "clássicos" que são comumente usados hoje, incluindo o coeficiente de correlação , definido como um momento-produto; o método dos momentos para o ajuste das distribuições às amostras; O sistema de curvas contínuas de Pearson que forma a base das agora convencionais distribuições de probabilidade contínua; A distância de Chi é um precursor e caso especial da distância de Mahalanobis e do valor P , definido como a medida de probabilidade do complemento da bola com o valor hipotético como ponto central e a distância de chi como raio. Ele também introduziu o termo 'desvio padrão'.

Ele também fundou a teoria do teste de hipótese estatística , o teste qui-quadrado de Pearson e a análise de componentes principais . Em 1911, ele fundou o primeiro departamento de estatística universitária do mundo na University College London .

A segunda onda de estatística matemática foi iniciada por Ronald Fisher, que escreveu dois livros didáticos, Métodos Estatísticos para Trabalhadores de Pesquisa , publicados em 1925 e O Projeto de Experimentos em 1935, que definiriam a disciplina acadêmica em universidades ao redor do mundo. Ele também sistematizou os resultados anteriores, colocando-os em uma base matemática sólida. Em seu artigo seminal de 1918, A Correlação entre Parentes na Suposição da Herança Mendeliana , o primeiro usou o termo estatístico variância . Em 1919, na Estação Experimental de Rothamsted, ele iniciou um grande estudo das extensas coleções de dados registrados ao longo de muitos anos. Isso resultou em uma série de relatórios sob o título geral Studies in Crop Variation. Em 1930, ele publicou A Teoria Genética da Seleção Natural, onde aplicou a estatística à evolução .

Nos sete anos seguintes, ele foi pioneiro nos princípios do projeto de experimentos (veja abaixo) e elaborou seus estudos de análise de variância. Ele aprofundou seus estudos das estatísticas de pequenas amostras. Talvez ainda mais importante, ele começou sua abordagem sistemática da análise de dados reais como o trampolim para o desenvolvimento de novos métodos estatísticos. Ele desenvolveu algoritmos computacionais para analisar dados de seus projetos experimentais balanceados. Em 1925, esse trabalho resultou na publicação de seu primeiro livro, Métodos Estatísticos para Trabalhadores de Pesquisa . Este livro teve muitas edições e traduções nos últimos anos e tornou-se o trabalho de referência padrão para cientistas em muitas disciplinas. Em 1935, este livro foi seguido por The Design of Experiments , que também foi amplamente utilizado.

Além da análise de variância, Fisher nomeou e promoveu o método de estimativa de máxima verossimilhança . Fisher também originou os conceitos de suficiência , estatística auxiliar , discriminador linear de Fisher e informação de Fisher . Seu artigo sobre a distribuição produzindo as funções de erro de várias estatísticas conhecidas (1924) apresentou teste de Pearson qui-quadrado e William Sealy Gosset 's t no mesmo quadro como a distribuição de Gauss , e seu próprio parâmetro na análise de variância z de Fisher -distribuição (mais comumente usado décadas depois, na forma da distribuição F ). O nível de significância de 5% parece ter sido introduzido por Fisher em 1925. Fisher afirmou que os desvios que excedem o dobro do desvio padrão são considerados significativos. Antes desses desvios superiores a três vezes o erro provável era considerado significativo. Para uma distribuição simétrica, o erro provável é a metade do intervalo interquartil. Para uma distribuição normal, o erro provável é de aproximadamente 2/3 do desvio padrão. Parece que o critério de 5% de Fisher estava enraizado na prática anterior.

Outras contribuições importantes nessa época incluíram o coeficiente de correlação de classificação de Charles Spearman , que foi uma extensão útil do coeficiente de correlação de Pearson. William Sealy Gosset , o estatístico inglês mais conhecido por seu pseudônimo de Student , introduziu a distribuição t de Student , uma distribuição de probabilidade contínua útil em situações em que o tamanho da amostra é pequeno e o desvio padrão da população é desconhecido.

Egon Pearson (filho de Karl) e Jerzy Neyman introduziram os conceitos de erro " Tipo II ", poder de um teste e intervalos de confiança . Jerzy Neyman em 1934 mostrou que a amostragem aleatória estratificada era, em geral, um método melhor de estimativa do que a amostragem proposital (quota).

Projeto de experimentos

Em 1747, enquanto trabalhava como cirurgião em HM Bark Salisbury , James Lind realizou um experimento controlado para desenvolver uma cura para o escorbuto . Neste estudo, os casos de seus sujeitos "eram tão semelhantes quanto eu poderia tê-los", ou seja, ele forneceu requisitos de entrada rígidos para reduzir a variação externa. Os homens estavam emparelhados, o que fornecia bloqueio . De uma perspectiva moderna, o que falta é a alocação aleatória de pacientes para os tratamentos.

Lind é hoje frequentemente descrito como um experimentador de um fator de cada vez. Experimentos similares de um fator por vez (OFAT) foram realizados na Rothamsted Research Station na década de 1840 por Sir John Lawes para determinar o fertilizante inorgânico ideal para uso no trigo.

Uma teoria de inferência estatística foi desenvolvida por Charles S. Peirce em " Ilustrações da Lógica da Ciência " (1877-1878) e " A Teoria da Inferência Provável " (1883), duas publicações que enfatizaram a importância da inferência baseada em randomização em Estatisticas. Em outro estudo, Peirce atribuído aleatoriamente a um voluntários cego , com medidas repetidas projeto para avaliar a sua capacidade para discriminar pesos.

O experimento de Peirce inspirou outros pesquisadores em psicologia e educação, que desenvolveram uma tradição de pesquisa de experimentos aleatórios em laboratórios e livros especializados no século XIX. Peirce também contribuiu a primeira publicação em língua Inglês em um projeto ideal para a regressão - modelos em 1876. Um pioneiro projeto ideal para a regressão polinomial foi sugerido por Gergonne em 1815. Em 1918 Kirstine Smith publicada designs mais eficientes para polinômios de grau seis (e menos) .

O uso de uma sequência de experimentos, onde o desenho de cada um pode depender dos resultados de experimentos anteriores, incluindo a possível decisão de parar de experimentar, foi pioneiro por Abraham Wald no contexto de testes sequenciais de hipóteses estatísticas. Pesquisas estão disponíveis de designs sequenciais ideais e de designs adaptativos . Um tipo específico de desenho sequencial é o "bandido de dois braços", generalizado para o bandido de vários braços , no qual o trabalho inicial foi feito por Herbert Robbins em 1952.

O termo "projeto de experimentos" (DOE) deriva dos primeiros trabalhos estatísticos realizados por Sir Ronald Fisher . Ele foi descrito por Anders Hald como "um gênio que quase sozinho criou as bases para a ciência estatística moderna". Fisher iniciou os princípios de planejamento de experimentos e elaborou seus estudos de " análise de variância ". Talvez ainda mais importante, Fisher começou sua abordagem sistemática da análise de dados reais como o trampolim para o desenvolvimento de novos métodos estatísticos. Ele começou a dar atenção especial ao trabalho envolvido nos cálculos necessários realizados à mão, e desenvolveu métodos que eram tão práticos quanto baseados no rigor. Em 1925, esse trabalho culminou com a publicação de seu primeiro livro, Statistical Methods for Research Workers . Em muitas edições e traduções nos anos posteriores, tornou-se um trabalho de referência padrão para cientistas em muitas disciplinas.

Uma metodologia para projetar experimentos foi proposta por Ronald A. Fisher , em seu livro inovador The Design of Experiments (1935), que também se tornou um padrão. Como exemplo, ele descreveu como testar a hipótese de que uma certa senhora poderia distinguir apenas pelo sabor se o leite ou o chá eram primeiro colocados na xícara. Embora pareça uma aplicação frívola, permitiu-lhe ilustrar as ideias mais importantes do design experimental: consulte Lady degustando o chá .

Os avanços da ciência agrícola serviram para atender à combinação de populações urbanas maiores e menos fazendas. Mas, para que os cientistas agrícolas levassem em conta as necessidades e climas geográficos de cultivo amplamente diferentes, era importante diferenciar as condições locais de cultivo. Para extrapolar experimentos em safras locais para uma escala nacional, eles tiveram que estender os testes de amostras de safras economicamente para as populações em geral. À medida que os métodos estatísticos avançavam (principalmente a eficácia de experimentos planejados em vez de experimentação de um fator de cada vez), o planejamento fatorial representativo de experimentos começou a permitir a extensão significativa, por inferência, dos resultados de amostragem experimental para a população como um todo . Mas era difícil decidir o quão representativa foi a amostra da cultura escolhida. A metodologia de planejamento fatorial mostrou como estimar e corrigir qualquer variação aleatória dentro da amostra e também nos procedimentos de coleta de dados.

Estatísticas bayesianas

O termo bayesiano refere-se a Thomas Bayes (1702-1761), que provou que limites probabilísticos podem ser colocados em um evento desconhecido. No entanto, foi Pierre-Simon Laplace (1749-1827) quem introduziu (como princípio VI) o que agora é chamado de teorema de Bayes e o aplicou à mecânica celeste , estatística médica, confiabilidade e jurisprudência . Quando não havia conhecimento suficiente para especificar um prior informado, Laplace usava prior uniformes , de acordo com seu " princípio da razão insuficiente ". Laplace assumiu precedentes uniformes por simplicidade matemática, e não por razões filosóficas. Laplace também introduziu versões primitivas de priors conjugados e o teorema de von Mises e Bernstein , de acordo com o qual os posteriores correspondentes a priors inicialmente diferentes concordam em última análise, conforme o número de observações aumenta. Essa inferência bayesiana inicial, que usava precedentes uniformes seguindo o princípio da razão insuficiente de Laplace , foi chamada de " probabilidade inversa " (porque infere de trás para frente das observações para os parâmetros, ou dos efeitos para as causas).

Após a década de 1920, a probabilidade inversa foi amplamente suplantada por uma coleção de métodos desenvolvidos por Ronald A. Fisher , Jerzy Neyman e Egon Pearson . Seus métodos passaram a ser chamados de estatísticas frequentistas . Fisher rejeitou a visão bayesiana, escrevendo que "a teoria da probabilidade inversa se baseia em um erro e deve ser totalmente rejeitada". No final de sua vida, entretanto, Fisher expressou maior respeito pelo ensaio de Bayes, que Fisher acreditava ter antecipado sua própria abordagem fiducial da probabilidade; Fisher ainda afirmava que as opiniões de Laplace sobre a probabilidade eram "lixo falacioso". Neyman começou como um "quase bayesiano", mas posteriormente desenvolveu intervalos de confiança (um método chave nas estatísticas frequentistas) porque "toda a teoria pareceria melhor se fosse construída desde o início sem referência ao bayesianismo e aos antecedentes". A palavra bayesiana surgiu por volta de 1950 e, na década de 1960, tornou-se o termo preferido por aqueles insatisfeitos com as limitações das estatísticas frequentistas.

No século XX, as ideias de Laplace foram se desenvolvendo em duas direções diferentes, dando origem a correntes objetivas e subjetivas na prática bayesiana. Na corrente objetivista, a análise estatística depende apenas do modelo assumido e dos dados analisados. Nenhuma decisão subjetiva precisa ser envolvida. Em contraste, os estatísticos "subjetivistas" negam a possibilidade de uma análise totalmente objetiva para o caso geral.

No desenvolvimento posterior das idéias de Laplace, as idéias subjetivas precedem as posições objetivistas. A ideia de que 'probabilidade' deve ser interpretada como 'grau subjetivo de crença em uma proposição' foi proposta, por exemplo, por John Maynard Keynes no início dos anos 1920. Essa ideia foi levada adiante por Bruno de Finetti na Itália ( Fondamenti Logici del Ragionamento Probabilistico , 1930) e Frank Ramsey em Cambridge ( The Foundations of Mathematics , 1931). A abordagem foi concebida para resolver problemas com a definição frequentista de probabilidade, mas também com a abordagem objetivista anterior de Laplace. Os métodos Bayesianos subjetivos foram desenvolvidos e popularizados na década de 1950 por LJ Savage .

A inferência Bayesiana objetiva foi desenvolvida posteriormente por Harold Jeffreys na Universidade de Cambridge . Seu livro seminal "Teoria da probabilidade" apareceu pela primeira vez em 1939 e desempenhou um papel importante no renascimento da visão bayesiana da probabilidade . Em 1957, Edwin Jaynes promoveu o conceito de entropia máxima para a construção de prioris, que é um princípio importante na formulação de métodos objetivos, principalmente para problemas discretos. Em 1965, o trabalho de 2 volumes de Dennis Lindley "Introdução à Probabilidade e Estatística de um Ponto de Vista Bayesiano" levou os métodos bayesianos a um público amplo. Em 1979, José-Miguel Bernardo introduziu a análise de referência , que oferece um quadro geral aplicável à análise objetiva. Outros proponentes bem conhecidos da teoria da probabilidade bayesiana incluem IJ Good , BO Koopman , Howard Raiffa , Robert Schlaifer e Alan Turing .

Na década de 1980, houve um crescimento dramático nas pesquisas e aplicações de métodos bayesianos, principalmente atribuídos à descoberta dos métodos de Monte Carlo da cadeia de Markov , que removeram muitos dos problemas computacionais , e um interesse crescente em aplicações complexas não padronizadas. Apesar do crescimento da pesquisa bayesiana, a maior parte do ensino de graduação ainda se baseia em estatísticas frequentistas. No entanto, os métodos bayesianos são amplamente aceitos e usados, como por exemplo no campo do aprendizado de máquina .

Contribuidores importantes para as estatísticas

|

Referências

Bibliografia

- Freedman, D. (1999). “Da associação à causalidade: algumas observações sobre a história das estatísticas” . Ciência Estatística . 14 (3): 243–258. doi : 10.1214 / ss / 1009212409 .( Versão revisada, 2002 )

- Hald, Anders (2003). Uma história de probabilidade e estatística e suas aplicações antes de 1750 . Hoboken, NJ: Wiley. ISBN 978-0-471-47129-5.

- Hald, Anders (1998). A History of Mathematical Statistics de 1750 a 1930 . Nova York: Wiley. ISBN 978-0-471-17912-2.

- Kotz, S., Johnson, NL (1992,1992,1997). Breakthroughs in Statistics , Vols I, II, III. Springer ISBN 0-387-94037-5 , ISBN 0-387-94039-1 , ISBN 0-387-94989-5

- Pearson, Egon (1978). A História da Estatística nos séculos XVII e XVIII no contexto em mudança do pensamento intelectual, científico e religioso (Palestras de Karl Pearson dadas na University College London durante as sessões acadêmicas de 1921-1933) . Nova York: MacMillan Publishing Co., Inc. p. 744. ISBN 978-0-02-850120-8.

- Salsburg, David (2001). The Lady Tasting Tea: How Statistics Revolutionized Science in the Twentieth Century . ISBN 0-7167-4106-7

- Stigler, Stephen M. (1986). A história da estatística: a medição da incerteza antes de 1900 . Belknap Press / Harvard University Press. ISBN 978-0-674-40341-3.

- Stigler, Stephen M. (1999) Statistics on the Table: The History of Statistical Concepts and Methods . Harvard University Press. ISBN 0-674-83601-4

- David, HA (1995). "Primeira (?) Ocorrência de Termos Comuns em Estatística Matemática". The American Statistician . 49 (2): 121–133. doi : 10.2307 / 2684625 . JSTOR 2684625 .

links externos

- JEHPS: Publicações recentes na história da probabilidade e estatística

- Electronic Journ @ l for History of Probability and Statistics / Journ @ l Electronique d'Histoire des Probabilités et de la Statistique

- Números da História da Probabilidade e Estatística (Univ. De Southampton)

- Materiais para a História da Estatística (Universidade de York)

- Probabilidade e estatísticas nas primeiras páginas de usos (Universidade de Southampton)

- Usos anteriores de símbolos em probabilidade e estatística sobre os primeiros usos de vários símbolos matemáticos