Álgebra Linear - Linear algebra

Álgebra linear é o ramo da matemática referente a equações lineares , como:

mapas lineares como:

e suas representações em espaços vetoriais e por meio de matrizes .

A álgebra linear é fundamental para quase todas as áreas da matemática. Por exemplo, a álgebra linear é fundamental nas apresentações modernas da geometria , inclusive para definir objetos básicos como linhas , planos e rotações . Além disso, a análise funcional , um ramo da análise matemática, pode ser vista como a aplicação da álgebra linear a espaços de funções .

A álgebra linear também é usada na maioria das ciências e campos da engenharia , porque permite modelar muitos fenômenos naturais e computar com eficiência com esses modelos. Para sistemas não lineares , que não podem ser modelados com álgebra linear, é frequentemente usado para lidar com aproximações de primeira ordem , usando o fato de que o diferencial de uma função multivariada em um ponto é o mapa linear que melhor se aproxima da função perto desse ponto.

História

O procedimento para resolver equações lineares simultâneas agora chamadas de eliminação de Gauss aparece no antigo texto matemático chinês Capítulo Oito: Matrizes Retangulares dos Nove Capítulos sobre a Arte Matemática . Seu uso é ilustrado em dezoito problemas, com duas a cinco equações.

Os sistemas de equações lineares surgiram na Europa com a introdução em 1637 por René Descartes das coordenadas na geometria . Na verdade, nessa nova geometria, agora chamada de geometria cartesiana , as linhas e os planos são representados por equações lineares, e calcular suas interseções equivale a resolver sistemas de equações lineares.

Os primeiros métodos sistemáticos para resolver sistemas lineares usavam determinantes , considerados pela primeira vez por Leibniz em 1693. Em 1750, Gabriel Cramer os usou para dar soluções explícitas de sistemas lineares, agora chamados de regra de Cramer . Mais tarde, Gauss descreveu ainda mais o método de eliminação, que foi inicialmente listado como um avanço na geodésia .

Em 1844, Hermann Grassmann publicou sua "Teoria da Extensão", que incluía novos tópicos fundamentais do que hoje é chamado de álgebra linear. Em 1848, James Joseph Sylvester introduziu o termo matriz , que significa útero em latim .

A álgebra linear cresceu com as idéias observadas no plano complexo . Por exemplo, dois números w e z em ter uma diferença w - z , e os segmentos de linha e são do mesmo comprimento e direcção. Os segmentos são equipolentes . O sistema quadridimensional de quatérnios foi iniciado em 1843. O termo vetor foi introduzido como v = x i + y j + z k representando um ponto no espaço. A diferença de quatérnio p - q também produz um segmento equipolente a Outros sistemas numéricos hipercomplexos também usaram a ideia de um espaço linear com uma base .

Arthur Cayley introduziu a multiplicação de matrizes e a matriz inversa em 1856, tornando possível o grupo linear geral . O mecanismo de representação de grupo tornou-se disponível para descrever números complexos e hipercomplexos. Crucialmente, Cayley usou uma única letra para denotar uma matriz, tratando assim uma matriz como um objeto agregado. Ele também percebeu a conexão entre matrizes e determinantes e escreveu "haveria muito a dizer sobre esta teoria das matrizes que deveria, parece-me, preceder a teoria dos determinantes".

Benjamin Peirce publicou seu Linear Associative Algebra (1872), e seu filho Charles Sanders Peirce estendeu o trabalho mais tarde.

O telégrafo exigia um sistema explicativo, e a publicação de 1873 de A Treatise on Electricity and Magnetism instituiu uma teoria de campo de forças e exigiu geometria diferencial para expressão. A álgebra linear é geometria diferencial plana e serve em espaços tangentes a variedades . As simetrias eletromagnéticas do espaço-tempo são expressas pelas transformações de Lorentz , e muito da história da álgebra linear é a história das transformações de Lorentz .

A primeira definição moderna e mais precisa de um espaço vetorial foi introduzida por Peano em 1888; em 1900, surgiu uma teoria das transformações lineares de espaços vetoriais de dimensão finita. A álgebra linear assumiu sua forma moderna na primeira metade do século XX, quando muitas idéias e métodos dos séculos anteriores foram generalizados como álgebra abstrata . O desenvolvimento de computadores levou ao aumento da pesquisa em algoritmos eficientes para eliminação gaussiana e decomposições de matrizes, e a álgebra linear tornou-se uma ferramenta essencial para modelagem e simulações.

Espaços vetoriais

Até o século 19, a álgebra linear foi introduzida por meio de sistemas de equações lineares e matrizes . Na matemática moderna, a apresentação por meio de espaços vetoriais é geralmente preferida, por ser mais sintética , mais geral (não se limitando ao caso de dimensão finita) e conceitualmente mais simples, embora mais abstrata.

Um espaço vetorial sobre um campo F (freqüentemente o campo dos números reais ) é um conjunto V equipado com duas operações binárias que satisfazem os seguintes axiomas . Os elementos de V são chamados de vetores e os elementos de F são chamados de escalares . A primeira operação, a adição de vectores , leva quaisquer dois vectores de v e w e emite um terceiro vector v + w . A segunda operação, multiplicação escalar , pega qualquer escalar a e qualquer vetor v e gera um novo vetor a v . Os axiomas que a adição e a multiplicação escalar devem satisfazer são os seguintes. (Na lista abaixo, u , v e w são elementos arbitrários de V , e a e b são escalares arbitrários no campo F. )

| Axioma | Significação |

| Associatividade de adição | u + ( v + w ) = ( u + v ) + w |

| Comutatividade de adição | u + v = v + u |

| Elemento de identidade de adição | Existe um elemento 0 em V , chamado o vector de zero (ou simplesmente de zero ), de modo a que v + 0 = v para todos v em V . |

| Elementos inversos de adição | Para cada v em V , existe um elemento - v em V , chamado de inverso aditivo de v , tal que v + (- v ) = 0 |

| Distributividade da multiplicação escalar em relação à adição de vetor | a ( u + v ) = a u + a v |

| Distributividade da multiplicação escalar em relação à adição de campo | ( a + b ) v = a v + b v |

| Compatibilidade de multiplicação escalar com multiplicação de campo | a ( b v ) = ( ab ) v |

| Elemento de identidade da multiplicação escalar | 1 v = v , onde 1 denota a identidade multiplicativo de F . |

Os primeiros quatro axiomas significam que V é um grupo abeliano sob adição.

Um elemento de um espaço vetorial específico pode ter várias naturezas; por exemplo, pode ser uma sequência , uma função , um polinômio ou uma matriz . A álgebra linear se preocupa com as propriedades de tais objetos que são comuns a todos os espaços vetoriais.

Mapas lineares

Mapas lineares são mapeamentos entre espaços vetoriais que preservam a estrutura do espaço vetorial. Dados dois espaços vetoriais V e W sobre um campo F , um mapa linear (também chamado, em alguns contextos, transformação linear ou mapeamento linear) é um mapa

que é compatível com adição e multiplicação escalar, isto é

para quaisquer vectores de u , v em V e escalar um em F .

Isso implica que para quaisquer vetores u , v em V e escalares a , b em F , um tem

Quando V = W são o mesmo espaço vectorial, um mapa linear também é conhecido como um operador linear em V .

Um mapa linear bijetivo entre dois espaços vetoriais (ou seja, todo vetor do segundo espaço está associado a exatamente um no primeiro) é um isomorfismo . Como um isomorfismo preserva a estrutura linear, dois espaços vetoriais isomórficos são "essencialmente iguais" do ponto de vista da álgebra linear, no sentido de que não podem ser distinguidos pelo uso de propriedades do espaço vetorial. Uma questão essencial em álgebra linear é testar se um mapa linear é um isomorfismo ou não e, se não for um isomorfismo, encontrar seu alcance (ou imagem) e o conjunto de elementos que são mapeados para o vetor zero, chamado de kernel do mapa. Todas essas questões podem ser resolvidas usando a eliminação de Gauss ou alguma variante deste algoritmo .

Subespaços, extensão e base

O estudo daqueles subconjuntos de espaços vetoriais que são em si mesmos espaços vetoriais sob as operações induzidas é fundamental, da mesma forma que para muitas estruturas matemáticas. Esses subconjuntos são chamados de subespaços lineares . Mais precisamente, um subespaço linear de um espaço vectorial V ao longo de um campo F é um subconjunto W de V de modo a que u + v e um u são em W , para cada u , v em W , e cada um em F . (Essas condições são suficientes para implicar que W é um espaço vetorial.)

Por exemplo, dado um mapa linear , a imagem T ( V ) de V , e a imagem inversa T −1 ( 0 ) de 0 (chamada kernel ou espaço nulo ), são subespaços lineares de W e V , respectivamente.

Outra forma importante de formar um subespaço é considerar combinações lineares de um conjunto S de vetores: o conjunto de todas as somas

onde v 1 , v 2 , ..., v k estão em S , e um 1 , um 2 , ..., um k são em F formar um subespaço linear chamado o intervalo de S . O espaço de S é também a combinação de todos os subespaços lineares que contêm S . Em outras palavras, é o menor (para a relação de inclusão) linear subespaço contendo S .

Um conjunto de vetores é linearmente independente se nenhum estiver no intervalo dos outros. Equivalentemente, um conjunto S de vetores é linearmente independente se a única maneira de expressar o vetor zero como uma combinação linear de elementos de S for tomar zero para cada coeficiente

Um conjunto de vetores que abrange um espaço vetorial é denominado conjunto de abrangência ou conjunto gerador . Se um conjunto gerador S é linearmente dependente (que não é linearmente independente), em seguida, algum elemento w de S está no intervalo de um dos outros elementos de S , e a extensão iria permanecer o mesmo se uma remoção w de S . Pode-se continuar a remover elementos de S até obter um conjunto de abrangência linearmente independente . Um conjunto linearmente independente de tal modo que abrange um espaço vector V é chamado uma base de V . A importância das bases reside no fato de que são simultaneamente conjuntos geradores mínimos e conjuntos independentes máximos. Mais precisamente, se S é um conjunto linearmente independente, e T é um conjunto abrangente de modo que então há uma base B tal que

Quaisquer duas bases de um espaço vetorial V têm a mesma cardinalidade , que é chamada de dimensão de V ; este é o teorema da dimensão para espaços vetoriais . Além disso, dois espaços vetoriais sobre o mesmo campo F são isomórficos se e somente se eles têm a mesma dimensão.

Se qualquer base de V (e, portanto, todas as bases) tem um número finito de elementos, V é um espaço vetorial de dimensão finita . Se L é um subespaço de V , em seguida, dim L Â dim V . No caso em que V é de dimensão finita, a igualdade das dimensões implica L = V .

Se U 1 e U 2 são subespaços de V , então

onde denota a extensão de

Matrizes

As matrizes permitem a manipulação explícita de espaços vetoriais de dimensão finita e mapas lineares . Sua teoria é, portanto, uma parte essencial da álgebra linear.

Seja V um espaço vetorial de dimensão finita sobre um campo F , e ( v 1 , v 2 , ..., v m ) seja uma base de V (portanto m é a dimensão de V ). Por definição de uma base, o mapa

é um bijeç~ao a partir do conjunto das sequências de m elementos de F , Onto V . Este é um isomorfismo de espaços vetoriais, se equipado de sua estrutura padrão de espaço vetorial, onde a adição vetorial e a multiplicação escalar são feitas componente por componente.

Este isomorfismo permite representar um vetor pela sua imagem inversa sob este isomorfismo, ou seja, pelo vetor de coordenadas ou pela matriz coluna

Se W é outro espaço vetorial de dimensão finita (possivelmente o mesmo), com base um mapa linear f de W a V é bem definido por seus valores nos elementos de base, ou seja , f é bem representado pela lista dos correspondentes matrizes de coluna. Ou seja, se

para j = 1, ..., n , então f é representado pela matriz

com m linhas e n colunas.

A multiplicação de matrizes é definida de tal forma que o produto de duas matrizes é a matriz da composição dos mapas lineares correspondentes, e o produto de uma matriz e uma matriz de coluna é a matriz de coluna que representa o resultado da aplicação do mapa linear representado a o vetor representado. Conclui-se que a teoria dos espaços vetoriais de dimensão finita e a teoria das matrizes são duas linguagens diferentes para expressar exatamente os mesmos conceitos.

Duas matrizes que codificam a mesma transformação linear em bases diferentes são chamadas de semelhantes . Pode-se provar que duas matrizes são semelhantes se e somente se uma pode transformar uma na outra por operações elementares de linha e coluna . Para uma matriz representando um mapa linear de W para V , as operações de linha correspondem às alterações de bases em V e as operações de coluna correspondem às alterações de bases em W . Cada matriz é semelhante a uma matriz de identidade possivelmente delimitada por zero linhas e zero colunas. Em termos de espaços vetoriais, isso significa que, para qualquer mapa linear de W a V , existem bases tais que uma parte da base de W é mapeada bijetivamente em uma parte da base de V , e que os demais elementos da base de W , se houver, são mapeados para zero. A eliminação gaussiana é o algoritmo básico para encontrar essas operações elementares e provar esses resultados.

Sistemas lineares

Um conjunto finito de equações lineares em um conjunto finito de variáveis, por exemplo, ou é chamado de sistema de equações lineares ou sistema linear .

Os sistemas de equações lineares são uma parte fundamental da álgebra linear. Historicamente, a álgebra linear e a teoria da matriz foram desenvolvidas para resolver esses sistemas. Na apresentação moderna da álgebra linear por meio de espaços vetoriais e matrizes, muitos problemas podem ser interpretados em termos de sistemas lineares.

Por exemplo, deixe

-

( S )

ser um sistema linear.

A tal sistema, pode-se associar sua matriz

e seu vetor membro certo

Vamos T ser a transformação linear associado à matriz M . Uma solução do sistema ( S ) é um vetor

de tal modo que

que é um elemento do preimage de v por T .

Seja ( S ' ) o sistema homogêneo associado , onde os lados direitos das equações são colocados em zero:

-

( S ' )

As soluções de ( S' ) são exactamente os elementos do núcleo de T ou, de forma equivalente, M .

A eliminação gaussiana consiste em realizar operações elementares de linha na matriz aumentada

para colocá-lo na forma escalonada de linha reduzida . Essas operações de linha não alteram o conjunto de soluções do sistema de equações. No exemplo, a forma escalonada reduzida é

mostrando que o sistema ( S ) tem a solução única

Segue-se desta interpretação de matriz de sistemas lineares que os mesmos métodos podem ser aplicados para resolver sistemas lineares e para muitas operações em matrizes e transformações lineares, que incluem o cálculo dos ranks , kernels , matrizes inversas .

Endomorfismos e matrizes quadradas

Um endomorfismo linear é um mapa linear que mapeia um espaço vetorial V para si mesmo. Se V tem uma base de n elementos, tal endomorfismo é representado por uma matriz quadrada de tamanho n .

Com relação aos mapas lineares gerais, endomorfismos lineares e matrizes quadradas têm algumas propriedades específicas que tornam seu estudo uma parte importante da álgebra linear, que é usada em muitas partes da matemática, incluindo transformações geométricas , mudanças de coordenadas , formas quadráticas e muitas outras partes da matemática.

Determinante

O determinante de uma matriz quadrada A é definido como sendo

onde é o grupo de todas as permutações de n elementos, é uma permutação e a paridade da permutação. Uma matriz é invertível se e somente se o determinante for invertível (ou seja, diferente de zero se os escalares pertencerem a um campo).

A regra de Cramer é uma expressão de forma fechada , em termos de determinantes, da solução de um sistema de n equações lineares em n incógnitas . A regra de Cramer é útil para raciocinar sobre a solução, mas, exceto para n = 2 ou 3 , raramente é usada para calcular uma solução, uma vez que a eliminação de Gauss é um algoritmo mais rápido.

O determinante de um endomorfismo é o determinante da matriz que representa o endomorfismo em termos de alguma base ordenada. Essa definição faz sentido, uma vez que esse determinante independe da escolha da base.

Autovalores e autovetores

Se f é um endomorfismo linear de um espaço vectorial V ao longo de um campo F , um vector próprio da f é diferente de zero de um vector v de V de modo a que f ( v ) = AV para alguns escalar um em F . Este escalar a é um autovalor de f .

Se a dimensão de V é finita, e uma base foi escolhida, f e v podem ser representados, respectivamente, por uma matriz quadrada M e uma matriz coluna z ; a equação que define os autovetores e os autovalores torna-se

Usando a matriz de identidade I , cujas entradas são todas zero, exceto aquelas da diagonal principal, que são iguais a um, isso pode ser reescrito

Como z é suposto ser diferente de zero, isso significa que M - aI é uma matriz singular e, portanto, seu determinante é igual a zero. Os valores próprios são, portanto, as raízes do polinômio

Se V é de dimensão n , este é um polinômio mônico de grau n , denominado polinômio característico da matriz (ou do endomorfismo), e há, no máximo, n autovalores.

Se existe uma base que consiste apenas em autovetores, a matriz de f nesta base tem uma estrutura muito simples: é uma matriz diagonal tal que as entradas na diagonal principal são autovalores e as outras entradas são zero. Nesse caso, o endomorfismo e a matriz são diagonalizáveis . Mais geralmente, um endomorfismo e uma matriz também são ditos diagonalizáveis, se eles se tornam diagonalizáveis após estender o campo de escalares. Nesse sentido estendido, se o polinômio característico for livre de quadrados , a matriz é diagonalizável.

Uma matriz simétrica é sempre diagonalizável. Existem matrizes não diagonalizáveis, sendo a mais simples

(não pode ser diagonalizável, pois seu quadrado é a matriz zero e o quadrado de uma matriz diagonal diferente de zero nunca é zero).

Quando um endomorfismo não é diagonalizável, existem bases sobre as quais ele tem uma forma simples, embora não tão simples quanto a diagonal. A forma normal de Frobenius não precisa estender o campo de escalares e torna o polinômio característico imediatamente legível na matriz. A forma normal de Jordan requer a extensão do campo do escalar para conter todos os autovalores e difere da forma diagonal apenas por algumas entradas que estão logo acima da diagonal principal e são iguais a 1.

Dualidade

Uma forma linear é um mapa linear de um espaço vetorial sobre um campo para o campo de escalares , visto como um espaço vetorial sobre si mesmo. Equipado por adição pontual e multiplicação por um escalar, as formas lineares formam um espaço vetorial, chamado de espaço dual de , e geralmente denotado ou .

Se for uma base de (isso implica que V é finito-dimensional), então pode-se definir, para i = 1, ..., n , um mapa linear tal que e se j ≠ i . Esses mapas lineares formam uma base chamada de base dual de (Se V não for finito-dimensional, o pode ser definido de forma semelhante; eles são linearmente independentes, mas não formam uma base.)

Para dentro , o mapa

é uma forma linear em Isso define o mapa linear canônico de dentro do dual de chamado de bidual de . Este mapa canônico é um isomorfismo se for finito-dimensional, e isso permite a identificação com seu bidual. (No caso de dimensão infinita, o mapa canônico é injetivo, mas não sobrejetivo.)

Há, portanto, uma simetria completa entre um espaço vetorial de dimensão finita e seu dual. Isso motiva o uso frequente, neste contexto, da notação bra-ket

para denotar .

Mapa duplo

Deixar

ser um mapa linear. Para cada forma linear h em W , a função composta h ∘ f é uma forma linear em V . Isso define um mapa linear

entre os espaços duais, que é chamado de dual ou transposto de f .

Se V e W são de dimensão finita, e M é a matriz de f em termos de algumas bases ordenadas, então a matriz de sobre as bases duais é a transposta de M , obtida pela troca de linhas e colunas.

Se os elementos dos espaços vetoriais e seus duais são representados por vetores coluna, esta dualidade pode ser expressa em notação bra-ket por

Para destacar essa simetria, os dois membros dessa igualdade às vezes são escritos

Espaços de produto interno

Além desses conceitos básicos, a álgebra linear também estuda espaços vetoriais com estrutura adicional, como um produto interno . O produto interno é um exemplo de forma bilinear e dá ao espaço vetorial uma estrutura geométrica ao permitir a definição de comprimentos e ângulos. Formalmente, um produto interno é um mapa

que satisfaz os três axiomas a seguir para todos os vetores u , v , w em V e todos os escalares a em F :

-

Simetria conjugada :

- Em R , é simétrico.

-

Linearidade no primeiro argumento:

-

Definitividade positiva :

- com igualdade apenas para v = 0.

Podemos definir o comprimento de um vetor v em V por

e podemos provar a desigualdade de Cauchy-Schwarz :

Em particular, a quantidade

e assim podemos chamar essa quantidade de cosseno do ângulo entre os dois vetores.

Dois vetores são ortogonais se . Uma base ortonormal é uma base onde todos os vetores de base têm comprimento 1 e são ortogonais entre si. Dado qualquer espaço vetorial de dimensão finita, uma base ortonormal poderia ser encontrada pelo procedimento de Gram-Schmidt . Bases ortonormais são particularmente fáceis de lidar, pois se v = a 1 v 1 + ⋯ + a n v n , então .

O produto interno facilita a construção de muitos conceitos úteis. Por exemplo, dada uma transformação T , podemos definir seu conjugado Hermitiano T * como a transformação linear que satisfaz

Se T satisfaz TT * = T * T , chamamos de T normal . Acontece que matrizes normais são precisamente as matrizes que têm um sistema ortonormal de autovetores esse período V .

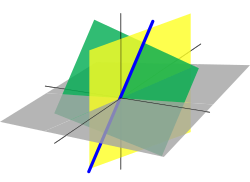

Relação com a geometria

Existe uma forte relação entre álgebra linear e geometria , que começou com a introdução por René Descartes , em 1637, das coordenadas cartesianas . Nessa nova (na época) geometria, agora chamada de geometria cartesiana , os pontos são representados por coordenadas cartesianas , que são sequências de três números reais (no caso do espaço tridimensional usual ). Os objetos básicos da geometria, que são linhas e planos, são representados por equações lineares. Assim, computar interseções de linhas e planos equivale a resolver sistemas de equações lineares. Esta foi uma das principais motivações para o desenvolvimento da álgebra linear.

A maioria das transformações geométricas , como translações , rotações , reflexos , movimentos rígidos , isometrias e projeções, transformam as linhas em linhas. Segue-se que eles podem ser definidos, especificados e estudados em termos de mapas lineares. Este é também o caso das homografias e das transformações de Möbius , quando consideradas como transformações de um espaço projetivo .

Até o final do século XIX, os espaços geométricos eram definidos por axiomas relacionando pontos, linhas e planos ( geometria sintética ). Por volta dessa data, parecia que também se podem definir espaços geométricos por construções envolvendo espaços vetoriais (ver, por exemplo, Espaço projetivo e Espaço afim ). Foi demonstrado que as duas abordagens são essencialmente equivalentes. Na geometria clássica, os espaços vetoriais envolvidos são espaços vetoriais sobre os reais, mas as construções podem ser estendidas para espaços vetoriais sobre qualquer campo, permitindo considerar a geometria sobre campos arbitrários, incluindo campos finitos .

Atualmente, a maioria dos livros didáticos introduz os espaços geométricos da álgebra linear, e a geometria é freqüentemente apresentada, no nível elementar, como um subcampo da álgebra linear.

Uso e aplicativos

A álgebra linear é usada em quase todas as áreas da matemática, o que a torna relevante em quase todos os domínios científicos que usam a matemática. Esses aplicativos podem ser divididos em várias categorias amplas.

Geometria do espaço ambiente

A modelagem do espaço ambiente é baseada na geometria . As ciências preocupadas com este espaço usam a geometria amplamente. É o caso da mecânica e da robótica , para descrever a dinâmica do corpo rígido ; geodésia para descrever a forma da Terra ; perspectiva , visão computacional e computação gráfica , para descrever a relação entre uma cena e sua representação plana; e muitos outros domínios científicos.

Em todas essas aplicações, a geometria sintética é freqüentemente usada para descrições gerais e uma abordagem qualitativa, mas para o estudo de situações explícitas, deve-se computar com coordenadas . Isso requer o uso pesado de álgebra linear.

Análise funcional

A análise funcional estuda os espaços funcionais . Esses são espaços vetoriais com estrutura adicional, como os espaços de Hilbert . A álgebra linear é, portanto, uma parte fundamental da análise funcional e suas aplicações, que incluem, em particular, a mecânica quântica ( funções de onda ).

Estudo de sistemas complexos

A maioria dos fenômenos físicos são modelados por equações diferenciais parciais . Para resolvê-los, geralmente se decompõe o espaço no qual as soluções são pesquisadas em pequenas células que interagem mutuamente . Para sistemas lineares, essa interação envolve funções lineares . Para sistemas não lineares , essa interação é freqüentemente aproximada por funções lineares. Em ambos os casos, matrizes muito grandes estão geralmente envolvidas. A previsão do tempo é um exemplo típico, onde toda a atmosfera da Terra é dividida em células de, digamos, 100 km de largura e 100 m de altura.

Computação científica

Quase todos os cálculos científicos envolvem álgebra linear. Consequentemente, os algoritmos de álgebra linear foram altamente otimizados. BLAS e LAPACK são as implementações mais conhecidas. Para aumentar a eficiência, alguns deles configuram os algoritmos automaticamente, em tempo de execução, para os adaptar às especificidades do computador ( tamanho da cache , número de núcleos disponíveis , ...).

Alguns processadores , normalmente unidades de processamento gráfico (GPU), são projetados com uma estrutura de matriz, para otimizar as operações de álgebra linear.

Extensões e generalizações

Esta seção apresenta vários tópicos relacionados que geralmente não aparecem em livros didáticos elementares de álgebra linear, mas são comumente considerados, em matemática avançada, como partes de álgebra linear.

Teoria do módulo

A existência de inversos multiplicativos em campos não está envolvida nos axiomas que definem um espaço vetorial. Pode-se então substituir o campo de escalares por um anel R , e isso dá uma estrutura chamada módulo sobre R , ou R- módulo.

Os conceitos de independência linear, amplitude, base e mapas lineares (também chamados de homomorfismos de módulo ) são definidos para módulos exatamente como para espaços vetoriais, com a diferença essencial de que, se R não é um campo, existem módulos que não os possuem. base. Os módulos que têm uma base são os módulos livres , e aqueles que são abrangidos por um conjunto finito são os módulos gerados finitamente . Homomorfismos de módulo entre módulos livres finitamente gerados podem ser representados por matrizes. A teoria das matrizes sobre um anel é semelhante à das matrizes sobre um campo, exceto que os determinantes existem apenas se o anel for comutativo , e que uma matriz quadrada sobre um anel comutativo é invertível apenas se seu determinante tiver um inverso multiplicativo no anel .

Os espaços vetoriais são completamente caracterizados por sua dimensão (até um isomorfismo). Em geral, não existe uma classificação tão completa para módulos, mesmo que se restrinja a módulos gerados finitamente. No entanto, cada módulo é um cokernel de um homomorfismo de módulos livres.

Módulos sobre inteiros podem ser identificados com grupos abelianos , uma vez que a multiplicação por um inteiro pode ser identificada como uma adição repetida. A maior parte da teoria de grupos abelianos pode ser estendida a módulos sobre um domínio ideal principal . Em particular, sobre um domínio ideal principal, cada submódulo de um módulo livre é livre, e o teorema fundamental de grupos abelianos finitamente gerados pode ser estendido diretamente para módulos gerados finitamente sobre um anel principal.

Existem muitos anéis para os quais existem algoritmos para resolver equações lineares e sistemas de equações lineares. No entanto, esses algoritmos geralmente têm uma complexidade computacional muito maior do que algoritmos semelhantes em um campo. Para obter mais detalhes, consulte Equação linear sobre um anel .

Álgebra multilinear e tensores

Na álgebra multilinear , consideram-se transformações lineares multivariáveis, ou seja, mapeamentos que são lineares em cada uma de uma série de variáveis diferentes. Esta linha de investigação leva naturalmente à ideia do espaço dual , o espaço vetorial V ∗ consistindo de mapas lineares f : V → F onde F é o campo dos escalares. Mapas multilineares T : V n → F podem ser descritos via produtos tensores de elementos de V ∗ .

Se, além da adição vetorial e da multiplicação escalar, houver um produto vetorial bilinear V × V → V , o espaço vetorial é denominado álgebra ; por exemplo, álgebras associativas são álgebras com um produto vetorial associado (como a álgebra de matrizes quadradas ou a álgebra de polinômios).

Espaços vetoriais topológicos

Espaços vetoriais que não são dimensionais finitos geralmente requerem estrutura adicional para serem tratáveis. Um espaço vetorial normado é um espaço vetorial junto com uma função chamada norma , que mede o "tamanho" dos elementos. A norma induz uma métrica , que mede a distância entre os elementos, e induz uma topologia , que permite a definição de mapas contínuos. A métrica também permite a definição de limites e integridade - um espaço métrico completo é conhecido como espaço de Banach . Um espaço métrico completo junto com a estrutura adicional de um produto interno (uma forma sesquilinear simétrica conjugada ) é conhecido como um espaço de Hilbert , que é, em certo sentido, um espaço de Banach particularmente bem comportado. A análise funcional aplica os métodos da álgebra linear juntamente com os da análise matemática para estudar vários espaços de função; os objetos centrais de estudo na análise funcional são os espaços L p , que são espaços de Banach, e especialmente o espaço L 2 de funções quadradas integráveis, que é o único espaço de Hilbert entre eles. A análise funcional é de particular importância para a mecânica quântica, a teoria das equações diferenciais parciais, processamento digital de sinais e engenharia elétrica. Ele também fornece a base e a estrutura teórica que fundamenta a transformada de Fourier e métodos relacionados.

Álgebra homológica

Veja também

- Matriz fundamental (visão computacional)

- Álgebra geométrica

- Programação linear

- Regressão linear , um método de estimativa estatística

- Lista de tópicos de álgebra linear

- Álgebra linear numérica

- Matriz de transformação

Notas

Referências

Fontes

- Anton, Howard (1987), Elementary Linear Algebra (5ª ed.), Nova York: Wiley , ISBN 0-471-84819-0

- Axler, Sheldon (18 de dezembro de 2014), Linear Algebra Done Right , Undergraduate Texts in Mathematics (3ª ed.), Springer Publishing (publicado em 2015), ISBN 978-3-319-11079-0

- Beauregard, Raymond A .; Fraleigh, John B. (1973), A First Course In Linear Algebra: with Optional Introduction to Groups, Rings, and Fields , Boston: Houghton Mifflin Company , ISBN 0-395-14017-X

- Burden, Richard L .; Faires, J. Douglas (1993), Numerical Analysis (5ª ed.), Boston: Prindle, Weber e Schmidt , ISBN 0-534-93219-3

- Golub, Gene H .; Van Loan, Charles F. (1996), Matrix Computations , Johns Hopkins Studies in Mathematical Sciences (3rd ed.), Baltimore: Johns Hopkins University Press , ISBN 978-0-8018-5414-9

- Halmos, Paul Richard (1974), Finite-Dimensional Vector Spaces , Undergraduate Texts in Mathematics (1958 2ª ed.), Springer Publishing , ISBN 0-387-90093-4, OCLC 1251216

- Harper, Charlie (1976), Introdução à Física Matemática , New Jersey: Prentice-Hall , ISBN 0-13-487538-9

- Katznelson, Yitzhak ; Katznelson, Yonatan R. (2008), A (concisa) Introdução à Álgebra Linear , American Mathematical Society , ISBN 978-0-8218-4419-9

- Roman, Steven (22 de março de 2005), Álgebra Linear Avançada , Textos de Graduação em Matemática (2ª ed.), Springer, ISBN 978-0-387-24766-3

Leitura adicional

História

- Fearnley-Sander, Desmond, " Hermann Grassmann and the Creation of Linear Algebra ", American Mathematical Monthly 86 (1979), pp. 809-817.

- Grassmann, Hermann (1844), Die lineale Ausdehnungslehre ein neuer Zweig der Mathematik: dargestellt und durch Anwendungen auf die übrigen Zweige der Mathematik, wie auch auf die Statik, Mechanik, die Lehre von e magnetismus und die Krystallie .

Livros didáticos introdutórios

- Anton, Howard (2005), Elementary Linear Algebra (Applications Version) (9ª ed.), Wiley International

- Banerjee, Sudipto; Roy, Anindya (2014), Linear Algebra and Matrix Analysis for Statistics , Textos em Ciência Estatística (1ª ed.), Chapman e Hall / CRC, ISBN 978-1420095388

- Bretscher, Otto (2004), Linear Algebra with Applications (3ª ed.), Prentice Hall, ISBN 978-0-13-145334-0

- Farin, Gerald; Hansford, Dianne (2004), Practical Linear Algebra: A Geometry Toolbox , AK Peters, ISBN 978-1-56881-234-2

- Hefferon, Jim (2020). Linear Algebra (4ª ed.). Ann Arbor, Michigan : Orthogonal Publishing. ISBN 978-1-944325-11-4. OCLC 1178900366 . OL 30872051M .

- Kolman, Bernard; Hill, David R. (2007), Elementary Linear Algebra with Applications (9ª ed.), Prentice Hall, ISBN 978-0-13-229654-0

- Lay, David C. (2005), Linear Algebra and Its Applications (3ª ed.), Addison Wesley, ISBN 978-0-321-28713-7

- Leon, Steven J. (2006), Linear Algebra With Applications (7ª ed.), Pearson Prentice Hall, ISBN 978-0-13-185785-8

- Murty, Katta G. (2014) Computational and Algorithmic Linear Algebra and n-Dimensional Geometry , World Scientific Publishing, ISBN 978-981-4366-62-5 . Capítulo 1: Sistemas de equações lineares simultâneas

- Poole, David (2010), Linear Algebra: A Modern Introduction (3ª ed.), Cengage - Brooks / Cole, ISBN 978-0-538-73545-2

- Ricardo, Henry (2010), A Modern Introduction to Linear Algebra (1ª ed.), CRC Press, ISBN 978-1-4398-0040-9

- Sadun, Lorenzo (2008), Álgebra Linear Aplicada: o princípio de desacoplamento (2ª ed.), AMS, ISBN 978-0-8218-4441-0

- Strang, Gilbert (2016), Introdução à Álgebra Linear (5ª ed.), Wellesley-Cambridge Press, ISBN 978-09802327-7-6

- The Manga Guide to Linear Algebra (2012), de Shin Takahashi , Iroha Inoue e Trend-Pro Co., Ltd., ISBN 978-1-59327-413-9

Livros didáticos avançados

- Bhatia, Rajendra (15 de novembro de 1996), Matrix Analysis , Graduate Texts in Mathematics , Springer, ISBN 978-0-387-94846-1

- Demmel, James W. (1 de agosto de 1997), Applied Numerical Linear Algebra , SIAM, ISBN 978-0-89871-389-3

- Dym, Harry (2007), Linear Algebra in Action , AMS, ISBN 978-0-8218-3813-6

- Gantmacher, Felix R. (2005), Applications of the Theory of Matrices , Dover Publications, ISBN 978-0-486-44554-0

- Gantmacher, Felix R. (1990), Matrix Theory Vol. 1 (2ª ed.), American Mathematical Society, ISBN 978-0-8218-1376-8

- Gantmacher, Felix R. (2000), Matrix Theory Vol. 2 (2ª ed.), American Mathematical Society, ISBN 978-0-8218-2664-5

- Gelfand, Israel M. (1989), Lectures on Linear Algebra , Dover Publications, ISBN 978-0-486-66082-0

- Glazman, IM; Ljubic, Ju. I. (2006), Análise Linear de Dimensão Finita , Publicações de Dover, ISBN 978-0-486-45332-3

- Golan, Johnathan S. (janeiro de 2007), The Linear Algebra a Beginning Graduate Student Ought to Know (2ª ed.), Springer, ISBN 978-1-4020-5494-5

- Golan, Johnathan S. (agosto de 1995), Foundations of Linear Algebra , Kluwer, ISBN 0-7923-3614-3

- Greub, Werner H. (16 de outubro de 1981), Linear Algebra , Graduate Texts in Mathematics (4ª ed.), Springer, ISBN 978-0-8018-5414-9

- Hoffman, Kenneth; Kunze, Ray (1971), Linear algebra (2ª ed.), Englewood Cliffs, NJ: Prentice-Hall, Inc., MR 0276251

- Halmos, Paul R. (20 de agosto de 1993), Espaços vetoriais de dimensão finita , Textos de graduação em matemática , Springer, ISBN 978-0-387-90093-3

- Friedberg, Stephen H .; Insel, Arnold J .; Spence, Lawrence E. (7 de setembro de 2018), Linear Algebra (5ª ed.), Pearson, ISBN 978-0-13-486024-4

- Horn, Roger A .; Johnson, Charles R. (23 de fevereiro de 1990), Matrix Analysis , Cambridge University Press, ISBN 978-0-521-38632-6

- Horn, Roger A .; Johnson, Charles R. (24 de junho de 1994), Topics in Matrix Analysis , Cambridge University Press, ISBN 978-0-521-46713-1

- Lang, Serge (9 de março de 2004), Linear Algebra , Undergraduate Texts in Mathematics (3ª ed.), Springer, ISBN 978-0-387-96412-6

- Marcus, Marvin; Minc, Henryk (2010), A Survey of Matrix Theory and Matrix Inequalities , Dover Publications, ISBN 978-0-486-67102-4

- Meyer, Carl D. (15 de fevereiro de 2001), Matrix Analysis and Applied Linear Algebra , Society for Industrial and Applied Mathematics (SIAM), ISBN 978-0-89871-454-8, arquivado do original em 31 de outubro de 2009

- Mirsky, L. (1990), An Introduction to Linear Algebra , Dover Publications, ISBN 978-0-486-66434-7

- Shafarevich, IR ; Remizov, A. O (2012), Linear Algebra and Geometry , Springer , ISBN 978-3-642-30993-9

- Shilov, Georgi E. (1 de junho de 1977), Linear algebra , Dover Publications, ISBN 978-0-486-63518-7

- Shores, Thomas S. (6 de dezembro de 2006), Applied Linear Algebra and Matrix Analysis , Undergraduate Texts in Mathematics, Springer, ISBN 978-0-387-33194-2

- Smith, Larry (28 de maio de 1998), Álgebra Linear , Textos de Graduação em Matemática, Springer, ISBN 978-0-387-98455-1

- Trefethen, Lloyd N .; Bau, David (1997), Numerical Linear Algebra , SIAM, ISBN 978-0-898-71361-9

Guias de estudo e esboços

- Leduc, Steven A. (1 de maio de 1996), Linear Algebra (Cliffs Quick Review) , Cliffs Notes, ISBN 978-0-8220-5331-6

- Lipschutz, Seymour; Lipson, Marc (6 de dezembro de 2000), Schaum's Outline of Linear Algebra (3ª ed.), McGraw-Hill, ISBN 978-0-07-136200-9

- Lipschutz, Seymour (1 de janeiro de 1989), 3.000 Solved Problems in Linear Algebra , McGraw – Hill, ISBN 978-0-07-038023-3

- McMahon, David (28 de outubro de 2005), Linear Algebra Demystified , McGraw – Hill Professional, ISBN 978-0-07-146579-3

- Zhang, Fuzhen (7 de abril de 2009), Linear Algebra: Challenging Problems for Students , The Johns Hopkins University Press, ISBN 978-0-8018-9125-0

links externos

Recursos online

- MIT Linear Algebra Video Lectures , uma série de 34 palestras gravadas pelo professor Gilbert Strang (primavera de 2010)

- Sociedade Internacional de Álgebra Linear

- "Linear algebra" , Encyclopedia of Mathematics , EMS Press , 2001 [1994]

- Álgebra Linear no MathWorld

- Termos matriciais e de álgebra linear nos primeiros usos conhecidos de algumas palavras da matemática

- Primeiros usos de símbolos para matrizes e vetores nos primeiros usos de vários símbolos matemáticos

- Essence of linear algebra , uma apresentação em vídeo de 3Blue1Brown dos fundamentos da álgebra linear, com ênfase na relação entre o geométrico, a matriz e os pontos de vista abstratos

Livros online

- Margalit, Dan; Rabinoff, Joseph (2019). Álgebra Linear Interativa . Instituto de Tecnologia da Geórgia , Atlanta, Geórgia : Auto-publicado.

- Beezer, Robert A. (2009) [2004]. Um primeiro curso de álgebra linear . Gainesville, Flórida : University Press of Florida . ISBN 9781616100049.

- Connell, Edwin H. (2004) [1999]. Elementos de Álgebra Abstrata e Linear . University of Miami , Coral Gables, Florida : Auto-publicado.

- Hefferon, Jim (2020). Linear Algebra (4ª ed.). Ann Arbor, Michigan : Orthogonal Publishing. ISBN 978-1-944325-11-4. OCLC 1178900366 . OL 30872051M .

- Matthews, Keith R. (2013) [1991]. Álgebra Linear Elementar . University of Queensland , Brisbane, Australia : Auto-publicado.

- Mikaelian, Vahagn H. (2020) [2017]. Álgebra Linear: Teoria e Algoritmos . Yerevan, Armênia : Auto-publicado - via ResearchGate .

- Sharipov, Ruslan, Curso de álgebra linear e geometria multidimensional

- Treil, Sergei, Álgebra Linear Done Wrong

![{\ displaystyle M = \ left [{\ begin {array} {rrr} 2 & 1 & -1 \\ - 3 & -1 & 2 \\ - 2 & 1 & 2 \ end {array}} \ right].}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fc5140ca13be8f555186b8d57b6223a4ef2e1b0b)

![{\ displaystyle \ left [\! {\ begin {array} {c | c} M & \ mathbf {v} \ end {array}} \! \ right] = \ left [{\ begin {array} {rrr | r } 2 & 1 & -1 & 8 \\ - 3 & -1 & 2 & -11 \\ - 2 & 1 & 2 & -3 \ end {array}} \ right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6a94bf6a98576cd520287535af3a6587376f9be8)

![{\ displaystyle \ left [\! {\ begin {array} {c | c} M & \ mathbf {v} \ end {array}} \! \ right] = \ left [{\ begin {array} {rrr | r } 1 & 0 & 0 & 2 \\ 0 & 1 & 0 & 3 \\ 0 & 0 & 1 & -1 \ end {array}} \ right],}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a6a99163495ae1cf328208d89cadcdf23397fba0)