METEOR - METEOR

METEOR ( Métrica para Avaliação de Tradução com ORdering Explícito ) é uma métrica para avaliação de saída de tradução automática . A métrica é baseada na média harmônica da precisão e recall do unigrama , com o recall mais pesado do que a precisão. Ele também tem vários recursos que não são encontrados em outras métricas, como lematização e correspondência de sinonímia , junto com a correspondência exata padrão de palavras. A métrica foi projetada para corrigir alguns dos problemas encontrados na métrica BLEU mais popular e também produzir uma boa correlação com o julgamento humano no nível da frase ou do segmento. Isso difere da métrica BLEU porque o BLEU busca correlação no nível do corpus.

Os resultados foram apresentados, em que correlação de até 0,964 com o julgamento humano ao nível do corpo, em comparação com BLEU realização 's de 0,817 no mesmo conjunto de dados. No nível da sentença, a correlação máxima alcançada com o julgamento humano foi de 0,403.

Algoritmo

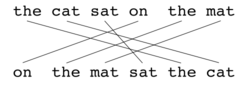

Tal como acontece com o BLEU , a unidade básica de avaliação é a frase, o algoritmo primeiro cria um alinhamento (veja as ilustrações) entre duas frases , a string de tradução candidata e a string de tradução de referência. O alinhamento é um conjunto de mapeamentos entre unigramas . Um mapeamento pode ser pensado como uma linha entre um unigrama em uma string e um unigrama em outra string. As restrições são as seguintes; cada unigrama na tradução candidata deve ser mapeado para zero ou um unigrama na referência. Os mapeamentos são selecionados para produzir um alinhamento conforme definido acima. Se houver dois alinhamentos com o mesmo número de mapeamentos, o alinhamento é escolhido com o menor número de cruzamentos , ou seja, com menos interseções de dois mapeamentos. Dos dois alinhamentos mostrados, o alinhamento (a) seria selecionado neste ponto. Os estágios são executados consecutivamente e cada estágio apenas adiciona ao alinhamento aqueles unigramas que não foram combinados nos estágios anteriores. Uma vez que o alinhamento final é calculado, a pontuação é calculada da seguinte forma: A precisão do unigrama P é calculada como:

| Módulo | Candidato | Referência | Partida |

|---|---|---|---|

| Exato | Bom | Bom | sim |

| Stemmer | Bens | Bom | sim |

| Sinonímia | Nós vamos | Bom | sim |

Onde m é o número de unigramas na tradução candidata que também são encontrados na tradução de referência e é o número de unigramas na tradução candidata. A rechamada do unigrama R é calculada como:

Onde m é como acima, e é o número de unigramas na tradução de referência. A precisão e o recall são combinados usando a média harmônica da seguinte maneira, com o recall pesando 9 vezes mais do que a precisão:

As medidas que foram introduzidas até agora só levam em conta a congruência com respeito a palavras isoladas, mas não com respeito a segmentos maiores que aparecem tanto na referência quanto na frase candidata. A fim de levar isso em consideração, correspondências mais longas de n -grama são usadas para calcular uma penalidade p para o alinhamento. Quanto mais mapeamentos houver que não sejam adjacentes na referência e na frase candidata, maior será a penalidade.

Para calcular essa penalidade, os unigramas são agrupados no menor número possível de pedaços , onde um pedaço é definido como um conjunto de unigramas adjacentes na hipótese e na referência. Quanto mais longos forem os mapeamentos adjacentes entre o candidato e a referência, menos blocos haverá. Uma tradução idêntica à referência fornecerá apenas um pedaço. A penalidade p é calculada da seguinte forma,

Onde c é o número de blocos e é o número de unigramas que foram mapeados. A pontuação final de um segmento é calculada como M abaixo. A penalidade tem o efeito de reduzir em até 50% se não houver bigrama ou correspondências mais longas.

Para calcular uma pontuação em um corpus inteiro , ou coleção de segmentos, os valores agregados para P , R e p são tomados e então combinados usando a mesma fórmula. O algoritmo também funciona para comparar uma tradução candidata com mais de uma tradução de referência. Nesse caso, o algoritmo compara o candidato com cada uma das referências e seleciona a pontuação mais alta.

Exemplos

| Referência | a | gato | sentado | sobre | a | esteira |

|---|---|---|---|---|---|---|

| Hipótese | sobre | a | esteira | sentado | a | gato |

| Pontuação | ||||||

| Fmean | ||||||

| Pena | ||||||

| Fragmentação | ||||||

| Referência | a | gato | sentado | sobre | a | esteira |

|---|---|---|---|---|---|---|

| Hipótese | a | gato | sentado | sobre | a | esteira |

| Pontuação | ||||||

| Fmean | ||||||

| Pena | ||||||

| Fragmentação | ||||||

| Referência | a | gato | sentado | sobre | a | esteira | |

|---|---|---|---|---|---|---|---|

| Hipótese | a | gato | estava | sentado | sobre | a | esteira |

| Pontuação | |||||||

| Fmean | |||||||

| Pena | |||||||

| Fragmentação | |||||||

Veja também

- BLEU

- F-Measure

- NIST (métrico)

- ROUGE (métrico)

- Taxa de erros de palavras (WER)

- LEPOR

- Chunking de substantivos

Notas

- ^ Banerjee, S. e Lavie, A. (2005)

Referências

- Banerjee, S. e Lavie, A. (2005) "METEOR: An Automatic Metric for MT Evaluation with Improved Correlation with Human Judgments" in Proceedings of Workshop on Intrinsic and Extrinsic Evaluation Measures for MT and / or Summarization in the 43rd Annual Meeting of a Associação de Lingüística Computacional (ACL-2005), Ann Arbor, Michigan, junho de 2005

- Lavie, A., Sagae, K. e Jayaraman, S. (2004) "The Significance of Recall in Automatic Metrics for MT Evaluation" in Proceedings of AMTA 2004, Washington DC. Setembro de 2004

links externos

- O sistema de avaliação automática de tradução automática METEOR (incluindo link para download)