Problema de comparações múltiplas - Multiple comparisons problem

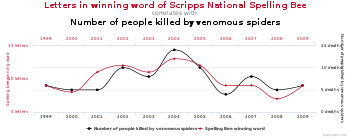

Em estatística , o problema de múltiplas comparações , multiplicidade ou teste múltiplo ocorre quando se considera um conjunto de inferências estatísticas simultaneamente ou infere um subconjunto de parâmetros selecionados com base nos valores observados. Em certos campos, é conhecido como efeito de olhar para outro lugar .

Quanto mais inferências são feitas, mais prováveis se tornam as inferências errôneas. Várias técnicas estatísticas foram desenvolvidas para resolver esse problema, normalmente exigindo um limite de significância mais rígido para comparações individuais, de modo a compensar o número de inferências feitas.

História

O problema das comparações múltiplas recebeu atenção crescente na década de 1950 com o trabalho de estatísticos como Tukey e Scheffé . Nas décadas seguintes, muitos procedimentos foram desenvolvidos para resolver o problema. Em 1996, a primeira conferência internacional sobre procedimentos de comparação múltipla ocorreu em Israel ; geralmente ocorre a cada dois anos em diferentes países de acolhimento.

Definição

Múltiplas comparações surgem quando uma análise estatística envolve vários testes estatísticos simultâneos, cada um dos quais com potencial para produzir uma "descoberta". Um nível de confiança declarado geralmente se aplica apenas a cada teste considerado individualmente, mas muitas vezes é desejável ter um nível de confiança para toda a família de testes simultâneos. A falha em compensar as comparações múltiplas pode ter consequências importantes no mundo real, conforme ilustrado pelos seguintes exemplos:

- Suponha que o tratamento seja uma nova forma de ensinar escrita aos alunos e o controle seja a forma padrão de ensinar escrita. Os alunos nos dois grupos podem ser comparados em termos de gramática, ortografia, organização, conteúdo e assim por diante. À medida que mais atributos são comparados, torna-se cada vez mais provável que os grupos de tratamento e controle pareçam diferir em pelo menos um atributo devido apenas ao erro de amostragem aleatória .

- Suponha que consideremos a eficácia de um medicamento em termos da redução de qualquer um dos vários sintomas da doença. À medida que mais sintomas são considerados, torna-se cada vez mais provável que o medicamento pareça ser uma melhoria em relação aos medicamentos existentes em termos de pelo menos um sintoma.

Em ambos os exemplos, conforme o número de comparações aumenta, torna-se mais provável que os grupos comparados pareçam diferir em termos de pelo menos um atributo. Nossa confiança de que um resultado será generalizado para dados independentes deve geralmente ser mais fraca se for observada como parte de uma análise que envolve múltiplas comparações, em vez de uma análise que envolve apenas uma única comparação.

Por exemplo, se um teste for executado no nível de 5% e a hipótese nula correspondente for verdadeira, haverá apenas 5% de chance de rejeitar incorretamente a hipótese nula. No entanto, se 100 testes forem conduzidos cada um no nível de 5% e todas as hipóteses nulas correspondentes forem verdadeiras, o número esperado de rejeições incorretas (também conhecido como falsos positivos ou erros Tipo I ) é 5. Se os testes forem estatisticamente independentes uns dos outros , a probabilidade de pelo menos uma rejeição incorreta é de aproximadamente 99,4%.

O problema de comparações múltiplas também se aplica a intervalos de confiança . Um único intervalo de confiança com um nível de probabilidade de cobertura de 95% conterá o valor verdadeiro do parâmetro em 95% das amostras. No entanto, se considerarmos 100 intervalos de confiança simultaneamente, cada um com 95% de probabilidade de cobertura, o número esperado de intervalos não abrangentes é 5. Se os intervalos forem estatisticamente independentes entre si, a probabilidade de que pelo menos um intervalo não contenha a população parâmetro é 99,4%.

Foram desenvolvidas técnicas para evitar a inflação de taxas de falsos positivos e taxas de não cobertura que ocorrem com vários testes estatísticos.

Classificação de múltiplos testes de hipótese

A tabela a seguir define os resultados possíveis ao testar várias hipóteses nulas. Suponha que temos um número m de hipóteses nulas, denotadas por: H 1 , H 2 , ..., H m . Usando um teste estatístico , rejeitamos a hipótese nula se o teste for declarado significativo. Não rejeitamos a hipótese nula se o teste não for significativo. A soma de cada tipo de resultado sobre todos os H i produz as seguintes variáveis aleatórias:

| A hipótese nula é verdadeira (H 0 ) | A hipótese alternativa é verdadeira (H A ) | Total | |

|---|---|---|---|

| O teste é declarado significativo | V | S | R |

| O teste foi declarado não significativo | você | T | |

| Total | m |

- m é o número total de hipóteses testadas

- é o número de hipóteses nulas verdadeiras , um parâmetro desconhecido

- é o número de hipóteses alternativas verdadeiras

- V é o número de falsos positivos (erro Tipo I) (também chamado de "descobertas falsas")

- S é o número de verdadeiros positivos (também chamados de "verdadeiras descobertas")

- T é o número de falsos negativos (erro Tipo II)

- U é o número de verdadeiros negativos

- é o número de hipóteses nulas rejeitadas (também chamadas de "descobertas", verdadeiras ou falsas)

Em m testes de hipótese dos quais são verdadeiras hipóteses nulas, R é uma variável aleatória observável e S , T , U e V são variáveis aleatórias não observáveis .

Procedimentos de controle

Se m comparações independentes são realizadas, a taxa de erro familiar (FWER), é dada por

Portanto, a menos que os testes sejam perfeitamente dependentes positivamente (ou seja, idênticos), aumenta à medida que o número de comparações aumenta. Se não assumirmos que as comparações são independentes, ainda podemos dizer:

que segue da desigualdade de Boole . Exemplo:

Existem diferentes maneiras de garantir que a taxa de erro familiar seja no máximo . O método mais conservador, que é livre de dependências e pressupostos distribucionais, é a correção de Bonferroni . Uma correção marginalmente menos conservadora pode ser obtida resolvendo a equação para a taxa de erro familiar de comparações independentes para . Isso produz , que é conhecido como a correção Šidák . Outro procedimento é o método Holm-Bonferroni , que fornece uniformemente mais potência do que a correção de Bonferroni simples, testando apenas o valor p mais baixo ( ) contra o critério mais estrito, e os valores p mais altos ( ) contra critérios progressivamente menos estritos. .

Para problemas contínuos, pode-se empregar a lógica bayesiana para calcular a partir da razão de volume anterior-posterior. Generalizações contínuas da correção de Bonferroni e Šidák são apresentadas em.

Correção de teste múltiplo

A correção de vários testes refere-se a tornar os testes estatísticos mais rigorosos a fim de neutralizar o problema dos testes múltiplos. O ajuste mais conhecido é a correção de Bonferroni , mas outros métodos foram desenvolvidos. Esses métodos são normalmente projetados para controlar a taxa de erro familiar ou a taxa de descoberta falsa .

Teste múltiplo em grande escala

Os métodos tradicionais para ajustes de múltiplas comparações se concentram na correção de números modestos de comparações, geralmente em uma análise de variância . Um conjunto diferente de técnicas foi desenvolvido para "testes múltiplos em grande escala", nos quais milhares ou até um número maior de testes são realizados. Por exemplo, em genômica , ao usar tecnologias como microarrays , os níveis de expressão de dezenas de milhares de genes podem ser medidos e genótipos para milhões de marcadores genéticos podem ser medidos. Particularmente no campo dos estudos de associação genética , tem havido um sério problema com a não replicação - um resultado sendo fortemente estatisticamente significativo em um estudo, mas não pode ser replicado em um estudo de acompanhamento. Essa não replicação pode ter muitas causas, mas é amplamente considerado que a falha em levar em conta totalmente as consequências de fazer comparações múltiplas é uma das causas. Tem sido argumentado que os avanços na medição e na tecnologia da informação tornaram muito mais fácil gerar grandes conjuntos de dados para análise exploratória , muitas vezes levando ao teste de um grande número de hipóteses sem base prévia para esperar que muitas das hipóteses sejam verdadeiras. Nessa situação, taxas de falsos positivos muito altas são esperadas, a menos que vários ajustes de comparação sejam feitos.

Para problemas de teste em grande escala em que o objetivo é fornecer resultados definitivos, a taxa de erro familiar continua sendo o parâmetro mais aceito para atribuir níveis de significância a testes estatísticos. Alternativamente, se um estudo é visto como exploratório, ou se resultados significativos podem ser facilmente testados novamente em um estudo independente, o controle da taxa de descoberta falsa (FDR) geralmente é preferível. O FDR, vagamente definido como a proporção esperada de falsos positivos entre todos os testes significativos, permite aos pesquisadores identificar um conjunto de "candidatos positivos" que podem ser avaliados com mais rigor em um estudo de acompanhamento.

A prática de tentar muitas comparações não ajustadas na esperança de encontrar uma significativa é um problema conhecido, aplicado de forma não intencional ou deliberada, às vezes é chamada de "p-hacking".

Avaliar se quaisquer hipóteses alternativas são verdadeiras

Uma questão básica enfrentada no início da análise de um grande conjunto de resultados de teste é se há evidências de que alguma das hipóteses alternativas é verdadeira. Um meta-teste simples que pode ser aplicado quando se assume que os testes são independentes um do outro é usar a distribuição de Poisson como um modelo para o número de resultados significativos em um determinado nível α que seriam encontrados quando todas as hipóteses nulas fossem verdade. Se o número de positivos observados for substancialmente maior do que o esperado, isso sugere que é provável que haja alguns positivos verdadeiros entre os resultados significativos. Por exemplo, se 1000 testes independentes forem realizados, cada um no nível α = 0,05, esperamos que 0,05 × 1000 = 50 testes significativos ocorram quando todas as hipóteses nulas forem verdadeiras. Com base na distribuição de Poisson com média 50, a probabilidade de observar mais de 61 testes significativos é menor que 0,05, portanto, se mais de 61 resultados significativos forem observados, é muito provável que alguns deles correspondam a situações em que a hipótese alternativa se sustenta. Uma desvantagem dessa abordagem é que ela superestima a evidência de que algumas das hipóteses alternativas são verdadeiras quando as estatísticas de teste são positivamente correlacionadas, o que normalmente ocorre na prática. Por outro lado, a abordagem permanece válida mesmo na presença de correlação entre as estatísticas de teste, desde que a distribuição de Poisson possa ser mostrada para fornecer uma boa aproximação para o número de resultados significativos. Este cenário surge, por exemplo, ao extrair conjuntos de itens frequentes significativos de conjuntos de dados transacionais. Além disso, uma análise cuidadosa de dois estágios pode limitar o FDR a um nível pré-especificado.

Outra abordagem comum que pode ser usada em situações em que as estatísticas de teste podem ser padronizadas para escores Z é fazer um gráfico de quantil normal das estatísticas de teste. Se os quantis observados são marcadamente mais dispersos do que os quantis normais, isso sugere que alguns dos resultados significativos podem ser verdadeiros positivos.

Veja também

- Conceitos chave

- Taxa de erro familiar

- Taxa de falsos positivos

- Taxa de descoberta falsa (FDR)

- Taxa de cobertura falsa (FCR)

- Estimativa de intervalo

- Análise Post-hoc

- Taxa de erro experimental

- Teste de hipótese estatística

- Métodos gerais de ajuste alfa para comparações múltiplas

- Procedimento de teste fechado

- Correção de Bonferroni

- Boole– Bonferroni vinculado

- Novo teste de alcance múltiplo de Duncan

- Método Holm-Bonferroni

- Procedimento de valor p médio harmônico

- Conceitos relacionados

- Testar hipóteses sugeridas pelos dados

- Falácia do atirador de elite do Texas

- Seleção de modelo

- Efeito de olhar para outro lugar

- Dragagem de dados

Referências

Leitura adicional

- F. Betz, T. Hothorn, P. Westfall (2010), Multiple Comparisons Using R , CRC Press

- S. Dudoit e MJ van der Laan (2008), Multiple Testing Procedures with Application to Genomics , Springer

- Farcomeni, A. (2008). "Uma revisão dos testes modernos de hipóteses múltiplas, com particular atenção à proporção de falsas descobertas". Métodos Estatísticos em Pesquisa Médica . 17 (4): 347–388. doi : 10.1177 / 0962280206079046 . PMID 17698936 . S2CID 12777404 .

- Phipson, B .; Smyth, GK (2010). "Os valores P de permutação nunca devem ser zero: Cálculo dos valores P exatos quando as permutações são desenhadas aleatoriamente". Aplicações estatísticas em genética e biologia molecular . 9 : Artigo 39. arXiv : 1603.05766 . doi : 10.2202 / 1544-6115.1585 . PMID 21044043 . S2CID 10735784 .

- PH Westfall e SS Young (1993), Resampling-based Multiple Testing: Examples and Methods for p-Value Adjustment , Wiley

- P. Westfall, R. Tobias, R. Wolfinger (2011) Comparações múltiplas e testes múltiplos usando SAS , 2ª ed., SAS Institute

- Uma galeria de exemplos de correlações implausíveis originadas por dragagem de dados