Cronograma de aprendizado de máquina - Timeline of machine learning

Esta página é uma linha do tempo do aprendizado de máquina . Principais descobertas, conquistas, marcos e outros eventos importantes estão incluídos.

Visão geral

| Década | Resumo |

|---|---|

| <1950s | Métodos estatísticos são descobertos e refinados. |

| Década de 1950 | A pesquisa pioneira em aprendizado de máquina é conduzida usando algoritmos simples. |

| Década de 1960 | Métodos bayesianos são introduzidos para inferência probabilística em aprendizado de máquina. |

| Década de 1970 | ' AI Winter ' causado pelo pessimismo sobre a eficácia do aprendizado de máquina. |

| Década de 1980 | A redescoberta da retropropagação causa um ressurgimento na pesquisa de aprendizado de máquina. |

| Década de 1990 | O trabalho no aprendizado de máquina muda de uma abordagem baseada no conhecimento para uma abordagem baseada em dados. Os cientistas começam a criar programas para computadores para analisar grandes quantidades de dados e tirar conclusões - ou "aprender" - com os resultados. Máquinas de vetores de suporte (SVMs) e redes neurais recorrentes (RNNs) se tornaram populares. Os campos de complexidade computacional via redes neurais e computação super-Turing começaram. |

| Década de 2000 | Support-Vector Clustering e outros métodos de kernel e métodos de aprendizado de máquina não supervisionados se espalham. |

| Década de 2010 | O aprendizado profundo se torna viável, o que faz com que o aprendizado de máquina se torne parte integrante de muitos serviços e aplicativos de software amplamente usados. |

Linha do tempo

| Ano | Tipo de evento | Rubrica | Evento |

|---|---|---|---|

| 1763 | Descoberta | Os fundamentos do teorema de Bayes | A obra de Thomas Bayes Um ensaio para a solução de um problema na doutrina das chances é publicada dois anos após sua morte, tendo sido corrigida e editada por um amigo de Bayes, Richard Price . O ensaio apresenta trabalhos que fundamentam o teorema de Bayes . |

| 1805 | Descoberta | Mínimo Quadrado | Adrien-Marie Legendre descreve o "méthode des moindres carrés", conhecido em inglês como o método dos mínimos quadrados . O método dos mínimos quadrados é amplamente utilizado no ajuste de dados . |

| 1812 | Teorema de Bayes | Pierre-Simon Laplace publica Théorie Analytique des Probabilités , na qual expande a obra de Bayes e define o que hoje é conhecido como Teorema de Bayes . | |

| 1913 | Descoberta | Cadeias de Markov | Andrey Markov primeiro descreve as técnicas que usou para analisar um poema. As técnicas mais tarde se tornaram conhecidas como cadeias de Markov . |

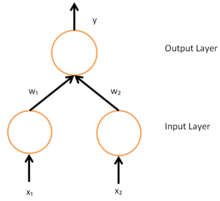

| 1943 | Descoberta | Neurônio Artificial | Warren McCulloch e Walter Pitts desenvolvem um modelo matemático que imita o funcionamento de um neurônio biológico, o neurônio artificial considerado o primeiro modelo neural inventado. |

| 1950 | Máquina de Aprendizagem de Turing | Alan Turing propõe uma 'máquina de aprendizado' que poderia aprender e se tornar artificialmente inteligente. A proposta específica de Turing prenuncia algoritmos genéticos . | |

| 1951 | Primeira Máquina de Rede Neural | Marvin Minsky e Dean Edmonds construíram a primeira máquina de rede neural capaz de aprender, o SNARC . | |

| 1952 | Máquinas jogando damas | Arthur Samuel se junta ao Laboratório Poughkeepsie da IBM e começa a trabalhar em alguns dos primeiros programas de aprendizado de máquina, primeiro criando programas que jogam damas . | |

| 1957 | Descoberta | Perceptron | Frank Rosenblatt inventa o perceptron enquanto trabalha no Laboratório Aeronáutico Cornell . A invenção do perceptron gerou grande empolgação e foi amplamente divulgada na mídia. |

| 1963 | Realização | Máquinas jogando jogo da velha | Donald Michie cria uma 'máquina' que consiste em 304 caixas de fósforos e contas, que usa o aprendizado de reforço para jogar o jogo da velha (também conhecido como zeros e cruzes). |

| 1967 | Vizinho mais próximo | O algoritmo de vizinho mais próximo foi criado, que é o início do reconhecimento de padrão básico. O algoritmo foi usado para mapear rotas. | |

| 1969 | Limitações das redes neurais | Marvin Minsky e Seymour Papert publicam seu livro Perceptrons , descrevendo algumas das limitações dos perceptrons e das redes neurais. A interpretação de que o livro mostra que as redes neurais são fundamentalmente limitadas é vista como um obstáculo para a pesquisa em redes neurais. | |

| 1970 | Diferenciação automática (retropropagação) | Seppo Linnainmaa publica o método geral para diferenciação automática (AD) de redes conectadas discretas de funções diferenciáveis aninhadas. Isso corresponde à versão moderna de retropropagação, mas ainda não foi nomeado como tal. | |

| 1979 | Stanford Cart | Os alunos da Universidade de Stanford desenvolvem um carrinho que pode navegar e evitar obstáculos em uma sala. | |

| 1979 | Descoberta | Neocognitron | Kunihiko Fukushima publica primeiro seu trabalho sobre o neocognitron , um tipo de rede neural artificial (RNA). A neocognição mais tarde inspira as redes neurais convolucionais (CNNs). |

| 1981 | Aprendizagem baseada na explicação | Gerald Dejong apresenta a Aprendizagem Baseada em Explicações, em que um algoritmo de computador analisa os dados e cria uma regra geral que pode seguir e descartar dados sem importância. | |

| 1982 | Descoberta | Rede Neural Recorrente | John Hopfield populariza as redes de Hopfield , um tipo de rede neural recorrente que pode servir como sistemas de memória endereçáveis por conteúdo . |

| 1985 | NetTalk | Um programa que aprende a pronunciar palavras da mesma forma que um bebê, foi desenvolvido por Terry Sejnowski. | |

| 1986 | Aplicativo | Retropropagação | O modo reverso de diferenciação automática de Seppo Linnainmaa (primeiro aplicado a redes neurais por Paul Werbos ) é usado em experimentos por David Rumelhart , Geoff Hinton e Ronald J. Williams para aprender representações internas . |

| 1989 | Descoberta | Aprendizagem por Reforço | Christopher Watkins desenvolve o Q-learning , que melhora muito a praticidade e a viabilidade do aprendizado por reforço . |

| 1989 | Comercialização | Comercialização de aprendizado de máquina em computadores pessoais | A Axcelis, Inc. lança o Evolver , o primeiro pacote de software a comercializar o uso de algoritmos genéticos em computadores pessoais. |

| 1992 | Realização | Máquinas Jogando Gamão | Gerald Tesauro desenvolve TD-Gammon , um programa de gamão de computador que usa uma rede neural artificial treinada usando aprendizagem de diferença temporal (daí o 'TD' no nome). TD-Gammon é capaz de rivalizar, mas não ultrapassar consistentemente, as habilidades dos melhores jogadores humanos de gamão. |

| 1995 | Descoberta | Algoritmo de floresta aleatório | Tin Kam Ho publica um artigo que descreve florestas de decisão aleatória . |

| 1995 | Descoberta | Máquinas de vetores de suporte | Corinna Cortes e Vladimir Vapnik publicam seu trabalho em máquinas de vetores de suporte . |

| 1997 | Realização | IBM Deep Blue bate Kasparov | O Deep Blue da IBM vence o campeão mundial no xadrez. |

| 1997 | Descoberta | LSTM | Sepp Hochreiter e Jürgen Schmidhuber inventam redes neurais recorrentes de memória de curto prazo longa (LSTM), melhorando muito a eficiência e praticidade das redes neurais recorrentes. |

| 1998 | Banco de dados MNIST | Uma equipe liderada por Yann LeCun libera o banco de dados MNIST , um conjunto de dados que compreende uma mistura de dígitos manuscritos de funcionários do American Census Bureau e alunos americanos do ensino médio. Desde então, o banco de dados MNIST se tornou uma referência para avaliar o reconhecimento de caligrafia . | |

| 2002 | Biblioteca de aprendizado de máquina da tocha | Torch , uma biblioteca de software para aprendizado de máquina, é lançada pela primeira vez. | |

| 2006 | O Prêmio Netflix | A competição do Prêmio Netflix é lançada pela Netflix . O objetivo da competição era usar o aprendizado de máquina para superar a precisão do software de recomendação da própria Netflix em prever a classificação de um usuário para um filme de acordo com suas classificações para filmes anteriores em pelo menos 10%. O prêmio foi conquistado em 2009. | |

| 2009 | Realização | ImageNet | ImageNet é criado. ImageNet é um grande banco de dados visual imaginado por Fei-Fei Li da Universidade de Stanford, que percebeu que os melhores algoritmos de aprendizado de máquina não funcionariam bem se os dados não refletissem o mundo real. Para muitos, a ImageNet foi o catalisador do boom da IA do século 21. |

| 2010 | Competição Kaggle | Kaggle , um site que serve de plataforma para competições de aprendizado de máquina, é lançado. | |

| 2011 | Realização | Derrotando humanos em perigo | Usando uma combinação de aprendizado de máquina, processamento de linguagem natural e técnicas de recuperação de informações, o Watson da IBM vence dois campeões humanos em um Jeopardy! concorrência. |

| 2012 | Realização | Reconhecendo gatos no YouTube | A equipe do Google Brain , liderada por Andrew Ng e Jeff Dean , cria uma rede neural que aprende a reconhecer gatos assistindo a imagens sem rótulos tiradas de quadros de vídeos do YouTube . |

| 2014 | Salto no reconhecimento facial | Os pesquisadores do Facebook publicam seus trabalhos no DeepFace , um sistema que usa redes neurais que identificam rostos com 97,35% de precisão. Os resultados são uma melhoria de mais de 27% em relação aos sistemas anteriores e rivalizam com o desempenho humano. | |

| 2014 | Sibila | Pesquisadores do Google detalham seu trabalho no Sibyl, uma plataforma proprietária para aprendizado de máquina massivamente paralelo usado internamente pelo Google para fazer previsões sobre o comportamento do usuário e fornecer recomendações. | |

| 2016 | Realização | Derrotar humanos em Go | O programa AlphaGo do Google se torna o primeiro programa Computer Go a vencer um jogador humano profissional sem deficiência usando uma combinação de aprendizado de máquina e técnicas de busca em árvore. Mais tarde, melhorou como AlphaGo Zero e, em 2017, generalizou para Xadrez e mais jogos para dois jogadores com AlphaZero . |

Veja também

- História da inteligência artificial

- Aprendizado de máquina

- Linha do tempo da inteligência artificial

- Linha do tempo da tradução automática